Hibernate ke Swap file

Bagi yang terbiasa memasang Linux tanpa partisi Swap seperti saya, tetapi ingin memanfaatkan fitur Hibernate/Hibernasi, Anda bisa membuat Swap dalam bentuk file. Saya terbiasa tidak membuat partisi Swap karena biasanya menggunakan Zram untuk kebutuhan Swap. Dengan Zram, komputer tetap responsif tanpa ada lag meskipun Swap terpakai, tapi kekurangannya yang saya rasakan adalah kita tidak bisa memanfaatkan fitur hibernate.

Buat apa fitur Hibernate untuk pengguna SSD, karena boot dari komputer mati biasanya justru lebih cepat daripada resume dari Hibernate? Karena saya kadang-kadang perlu mematikan komputer tanpa harus menyimpan pekerjaan terlebih dahulu. Dan jika menggunakan Sleep, jika laptop ditinggalkan lama karena pekerjaan lain atau karena lupa bisa membuat baterai kehabisan daya sehingga perkerjaan yang tersimpan hilang begitu saja.

Tapi dengan Hibernate, kita bisa memanfaatkan fitur Sleep Then Hibernate yang jika komputer/laptop dibiarkan Sleep dalam waktu tertentu, dia akan berpindah ke Hibernate. Bagi pengguna Plasma 5 fitur ini bisa diaktifkan di System Settings > Power Management > Energy Saving atau bisa langsung menggunakan Systemd.

Membuat Swap file bisa dilakukan dengan proses berikut:

Pertama buat file dengan fallocate. Untuk membuat Swap sebesar 4 GiB, gunakan 4096M atau 4G (sesuaikan dengan kebutuhan):

su -c "fallocate -l 4096M /swapfile"

Jika Anda menggunakan BtrFS dengan snapshot, sebaiknya buat swapfile di partisi lain, jadi ubah /swapfile dengan /path/ke/partisi/lain/swapfile. Dan yang perlu diperhatikan juga, untuk membuat Swapfile di BtrFS, Anda harus menggunakan Kernel 5 ke atas.

Lalu ubah hak akses supaya aman dari modifikasi pengguna lain:

su -c "chown -v 600 /swapfile"

Buat jadi Swap:

su -c "mkswap /swapfile"

Aktifkan Swap:

su -c "swapon /swapfile"

Masukkan ke /etc/fstab supaya Swap aktif saat komputer dinyalakan:

su -c "echo '/swapfile none swap defaults 0 0' >> /etc/fstab"

Supaya komputer bisa Resume dari Hibernate, kita perlu menambahkan kernel parameter resume dan resume_offset ke Grub. Parameter resume diisi dengan partisi di mana letak swapfile berada. Misal jika ada di /dev/sda2, isi dengan resume=/dev/sda2. Sedangkan resume_offset bisa diketahui dengan perintah filefrag, kecuali jika Anda membuat swapfile tersebut di BtrFS.

su -c "filefrag -v /swapfile"

Dari hasil perintah tersebut akan muncul hasil seperti ini:

Filesystem type is: ef53 File size of /swapfile is 4294967296 (1048576 blocks of 4096 bytes) ext: logical_offset: physical_offset: length: expected: flags: 0: 0.. 0: 17782784.. 17782784: 1: 1: 1.. 2047: 17782785.. 17784831: 2047: unwritten 2: 2048.. 32767: 18071552.. 18102271: 30720: 17784832: unwritten 3: 32768.. 63487: 18102272.. 18132991: 30720: unwritten 4: ....... .....: .......... ........: .....: .........

Parameter resume_offset diisi dengan angka pertama dari physical_offset. Jadi dengan hasil perintah di atas, diisi dengan resume_offset=17782784 (sesuaikan dengan hasil Anda).

Untuk mencari resume_offset di BtrFS bisa menggunakan btrfs_map_physical. Download file tersebut, compile, lalu jalankan.

Masukkan kedua parameter tersebut ke file /etc/default/grub pada opsi GRUB_CMDLINE_LINUX_DEFAULT. Jika kita memasang openSUSE dengan partisi Swap, parameter resume ini akan berada di antara splash=silent dan quiet. Kita juga bisa memasukkan kedua parameter di atas di tempat yang sama dengan perintah:

su -c "sed -i 's/silent/silent resume=\/dev\/sda2 resume_offset=17782784/g' /etc/default/grub"

Lalu update grub dengan perintah:

su -c "grub2-mkconfig -o /boot/grub2/grub.cfg"

Kekurangan dari Swap dalam bentuk file atau partisi adalah saat Swap terpakai komputer akan terasa berat/ngelag. Untuk mengantisipasi ini saya tetap membuat Swap dengan Zram dengan prioritas lebih tinggi. Caranya buat sebuah file di /usr/local/sbin/ dengan nama swap-zram, isi dengan:

#!/bin/bash

num_cpus=$(grep -c processor /proc/cpuinfo)

[ "$num_cpus" != 0 ] || num_cpus=1

decr_num_cpus=$((num_cpus - 1))

if [ "$1" -ne 0 ]; then

mod_parm=$(modinfo zram |grep parm |tr -s " " |cut -f2 -d ":")

modprobe zram $mod_parm=$num_cpus

for i in $(seq 0 $decr_num_cpus); do

echo $((($1 * 1024 * 1024) / num_cpus)) > /sys/block/zram$i/disksize

done

for i in $(seq 0 $decr_num_cpus); do

mkswap /dev/zram$i

done

for i in $(seq 0 $decr_num_cpus); do

swapon -p 100 /dev/zram$i

done

else

for i in $(seq 0 $decr_num_cpus); do

if [ "$(grep /dev/zram$i /proc/swaps)" != "" ]; then

swapoff /dev/zram$i

fi

done

rmmod zram

fi

Buat file tersebut supaya bisa dieksekusi:

su -c "chmod +x /usr/local/sbin/swap-zram"

Lalu buat sebuah folder di /usr/local/lib/ dengan nama systemd. Di dalamnya buat lagi folder dengan nama system. Perintahnya adalah:

su -c "mkdir -p /usr/local/lib/systemd/system"

Di dalam folder system, buat sebuah file dengan nama swap-zram.service. Isi dengan:

[Unit] Description=Service enabling compressing RAM with zRam After=multi-user.target [Service] Type=oneshot ExecStart=/usr/local/sbin/swap-zram 4096 ExecStop=/usr/local/sbin/swap-zram 0 RemainAfterExit=yes [Install] WantedBy=multi-user.target

Angka 4096 jika kita ingin membuat Swap dari Zram sebesar 4 GiB. Sehingga total Swap dengan Swapfile yang tadi dibuat menjadi 8 GiB. Silakan sesuaikan dengan kebutuhan.

Aktifkan dan jalankan service tersebut dengan:

su -c "systemctl enable swap-zram.service"

Dan

su -c "systemctl start swap-zram.service"

Kemeriahan #MozTalk – Open Source Day (openSUSE and Mozilla Firefox Edition)

19 Januari 2020, cuaca cukup cerah di bilangan Kuningan Barat, Jakarta. #MozTalk – Open Source Day (openSUSE and Mozilla Firefox Edition) dibuka oleh perwakilan dari Komunitas Mozilla Indonesia, lalu dilanjutkan oleh pembicara pertama dari Komunitas openSUSE Indonesia, yang diwakili oleh mas Kukuh Syafaat yang memperkenalkan kembali openSUSE. Perkenalan kembali dengan openSUSE dimulai dari openSUSE Project, teknologi yang ada di openSUSE, bagaimana cara berkontribusi di proyek FOSS, dan juga tentang Komunitas openSUSE Indonesia.

Pembicara kedua ada mas Herpiko Dwi Aguno dengan “Ngoprek Mozilla Firefox“. Mas Piko menjelaskan bagaimana berkontribusi langsung ke peramban Mozilla Firefox dari mulai mengirimkan kutu ke bugzilla, membangun Mozilla Firefox di lokal, membenahi kutu, dan bagaimana mengirimkan tambalan tersebut hingga akhirnya masuk dalam rilis.

Tidak ketinggalan, openSUSE-ID juga bagi-bagi hadiah untuk beberapa hadirin yang bertanya. Terima kasih kepada Komunitas Mozilla Indonesia yang sudah menyediakan tempat yang kece. Sampai jumpa di acara keren selanjutnya

Door prizes! Tanya saja, jangan sungkan

@openSUSE @ID_Mozilla @MozSpaceJKT pic.twitter.com/SLMNLv1vXc

— openSUSE Indonesia (@openSUSEID) January 19, 2020

Pengumuman Pemenang #KuisLiburan2019

Komunitas openSUSE Indonesia (openSUSE-ID) mengucapkan terima kasih atas antusiasme peserta pada #KuisLiburan2019 kali ini. Dari 127 jawaban yang masuk, kami harus mengkurasi jawaban yang salah maupun kurang tepat. Tersaring 42 jawaban yang tepat dan kami harus mengundi lagi untuk menentukan siapa peserta yang beruntung. Peserta yang beruntung adalah sebagai berikut.

Peserta yang beruntung untuk mendapatkan new SSD 120 GB adalah Sabilil Maromi.

sementara untuk peserta berikut mendapatkan bingkisan menarik dari openSUSE ID

- Arif Setyo Nugroho

- abi permana

- Heru Juwardi

- Aji Revaldi

- Surya Handika Putratama

- Yaumul Majid

- Muhammad Rofi

- Wuri Nugrahadi

- Arif Dermawan

- A Mu’ammar Afinas

- Rizal Amrr

- abdi weef

- Kristian Valent

- Rokib Munawir

- Satrio Adi Prawiro

- iqbalfr@nevtik.org

- gatoti

- lazuardi senja

- Muhamad Andhika Prasetya

Diharapkan kepada seluruh pemenang untuk mengirimkan informasi alamat dan nomor handphone di tautan berikut ini selambatnya tanggal 14 Januari 2020, jika sampai waktu tersebut tidak mengisi form pemenang maka hadiah dinyatakan hangus.

Bingkisan menarik akan dikirimkan oleh tim openSUSE-ID secara gratis! Jangan lupa bagi para pemenang untuk memposting bingkisan tersebut ke media sosial dengan tagar #KuisLiburan2019 #openSUSE dan mention ke @openSUSE dan @openSUSEID (di Twitter).

Selamat dan sampai jumpa lagi di Kuis berikutnya!

Salam,

High Availability PostgreSQL Cluster dengan Pgpool-II (Bagian ke-3)

TL;DR: Karena cukup panjang tulisan akan dibagi dalam 3 tulisan

- Bagian 1 : membahas instalasi dan konfigurasi master postgresql

- Bagian 2 : membahas instalasi dan konfigurasi slave postgresql

- Bagian 3 : membahas instalasi dan konfigurasi pgpool-II

Tulisan ini adalah Bagian ke-3.

4. Instalasi pgpool

Pgpool-II sudah terdapat di OBS repositori. Versinya sedikit terlambat dari versi rilis di web Pgpool. Saat tulisan ini dibuat versi Pgpool di website Pgpool adalah 4.1. Sementara paket di OBS repositori masih versi 4.0.6.

Tambah repositori, install pgpool dan postgresql. Sebenarnya postgresql di mesin pgpool kita butuhkan hanya clientnya saja, untuk mengakses database (psql) dan backup (pg_dump) misalnya. Tapi untuk memudahkan kita install juga postgresql-server walaupun tidak perlu dijalankan

zypper ar -e -f https://download.opensuse.org/repositories/server:/database:/postgresql/openSUSE_Leap_15.1/ postgresql

zypper in --no-recommends pgpool-II postgresql12-pgpool-II postgresql12 postgresql12-server postgresql12-contrib

Selanjutnya edit file /etc/hosts, misalnya pgsql1 untuk master, pgsql2 untuk slave1, pgsql3 untuk slave2.

127.0.0.1 localhost

10.100.1.5 pgpool

10.100.1.6 pgsql1

10.100.1.7 pgsql2

10.100.1.8 pgsql3

Perhatikan bahwa kita menginstal pula paket postgresql12-pgpool-II, paket ini berisi library dan extension pgpool untuk PostgreSQL, ditandai dengan .sql dan .control. File-filenya tersimpan di direktori /usr/lib/postgresql12/lib64/, /usr/lib/postgresql12/lib64/bitcode/ dan /usr/share/postgresql12/extension/.

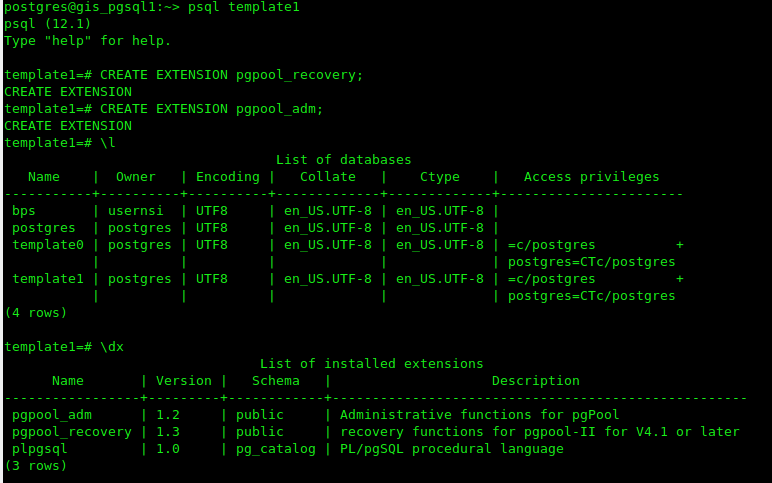

Langkah berikutnya kita memasang extension pgpool tersebut pada database postgresql. Kita pasang extension pgpool tersebut pada template1. Lakukan 1 kali saja di master karena nanti akan otomatis tereplikasi di slave.

sudo -i -u postgres

psql template1

CREATE EXTENSION pgpool_recovery;

CREATE EXTENSION pgpool_adm;

Periksa bahwa extension telah terpasang pada template1

\dx

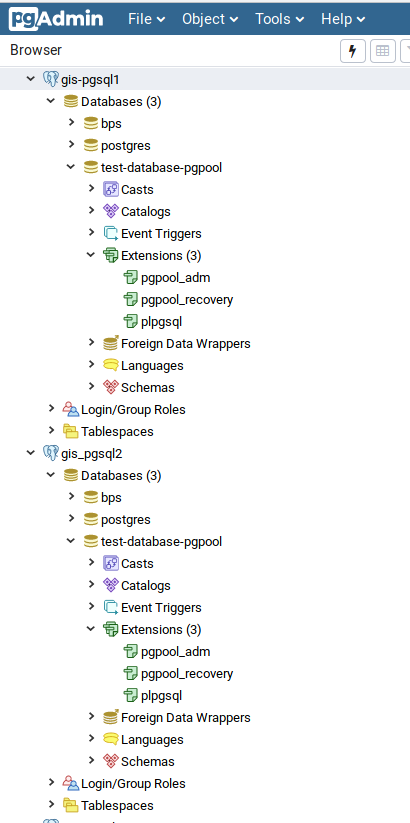

Pada master akan seperti

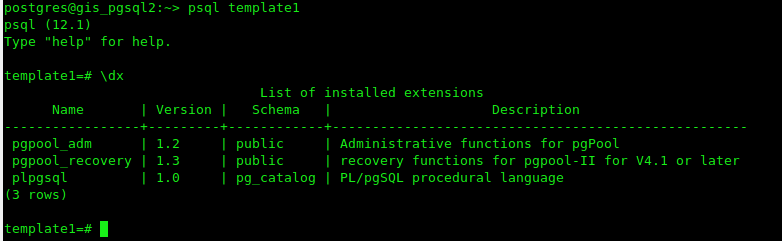

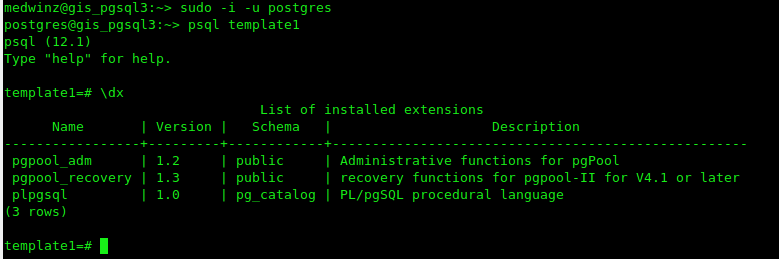

Pada slave

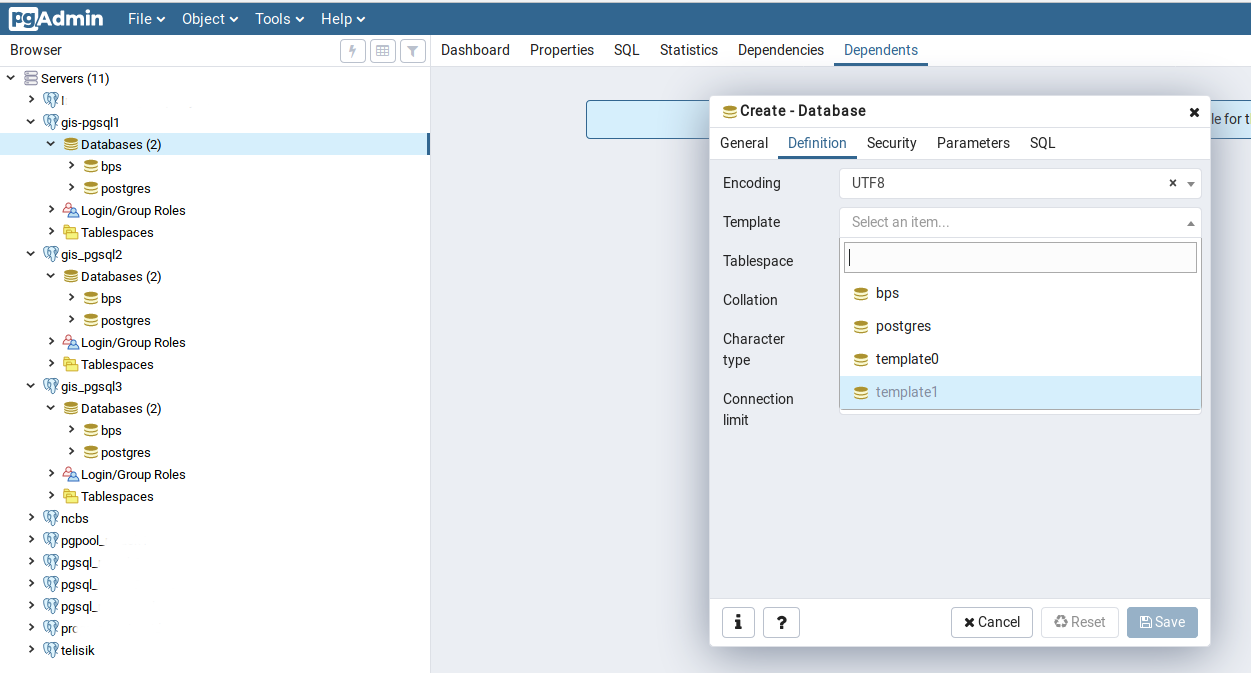

Pada saatnya nanti kita gunakan template1 sebagai template database yang akan kita buat sehingga otomatis database yang terbentuk akan memiliki extension pgpool. Misalnya gunakan pgadmin, buatlah sebuah database baru dengan dengan menggunakan template1 di master, maka database akan dibuat dengan extension pgpool_adm dan pgpool_recovery. Database dengan kondisi yang sama otomatis akan terbentuk di slave. Kalau berhasil artinya sulapan kita bekerja

Langkah berikutnya adalah mengkonfigurasi file /etc/pgpool-II/pcp.conf. File ini berisi user dan password pgpool untuk admnistrasi management pgpool. Password dihash md5 dan formatnya adalah

username:[md5 encrypted password]

Buat password dalam format md5 dengan

$ pg_md5 your_password

1060b7b46a3bd36b3a0d66e0127d0517

Atau jika anda tidak ingin memperlihatkan password anda dengan cara:

$ pg_md5 -p

password: your_password

Isi file pcp.conf dengan menggunakan hasil md5 tersebut misal

admin:97bf34d31a8710e6b1649fd33357f783Walaupun tidak wajib kita bisa mengisikan username dan password yang sama dengan user PostgreSQL agar mempermudah dalam mengakses dan mengingatnya.

Jangan lupa lengkapi file /etc/pgpool-II/pool_hba.conf dengan ip address dari masing-masing server PostgreSQL (sesuaikan dengan ip mesin master dan slave), misalnya

# "local" is for Unix domain socket connections only

local all all trust

# IPv4 local connections:

host all all 127.0.0.1/32 trust

host all all ::1/128 trust

host all all 10.100.1.6/32 md5

host all all 10.100.1.7/32 md5

host all all 10.100.1.8/32 md5Selanjutnya kita harus mengkonfigurasi file /etc/pgpool-II/pgpool.conf. Sesuai dengan dokumentasi pgpool maka running mode yang dianjurkan secara default adalah streaming replication mode. Dalam mode ini PostgreSQL bertanggung jawab terhadap sinkronisasi database. Load balancing dimungkinkan untuk dijalankan dalam mode ini. Contoh konfigurasinya diberikan ketika kita menginstall pgpool yaitu pada file /etc/pgpool-II/pgpool.conf.sample-stream. Di bawah ini adalah contoh dari /etc/pgpool-II/pgpool.conf

# - pgpool Connection Settings -

listen_addresses = '*'

port = 5432

socket_dir = '/var/run/pgpool'

# - pgpool Communication Manager Connection Settings -

pcp_listen_addresses = '*'

pcp_port = 9898

pcp_socket_dir = '/var/run/pgpool'

listen_backlog_multiplier = 2

serialize_accept = off

# - Backend Connection Settings -

backend_hostname0 = 'gis_pgsql1' # sesuaikan dengan HOSTNAME master postgresql

backend_port0 = 5432

backend_weight0 = 1

backend_data_directory0 = '/data'

backend_flag0 = 'ALLOW_TO_FAILOVER'

backend_hostname1 = 'gis_pgsql2' # sesuaikan dengan HOSTNAME slave postgresql

backend_port1 = 5432

backend_weight1 = 1

backend_data_directory1 = '/data'

backend_flag1 = 'ALLOW_TO_FAILOVER'

backend_hostname2 = 'gis_pgsql3' # sesuaikan dengan HOSTNAME slave postgresql

backend_port2 = 5432

backend_weight2 = 1

backend_data_directory2 = '/data'

backend_flag2 = 'ALLOW_TO_FAILOVER'

# - Authentication -

enable_pool_hba = on

pool_passwd = 'pool_passwd'

authentication_timeout = 60

allow_clear_text_frontend_auth = off

# - SSL Connections -

ssl = off

ssl_ciphers = 'HIGH:MEDIUM:+3DES:!aNULL'

ssl_prefer_server_ciphers = off

#------------------------------------------------------------------------------

# POOLS

#------------------------------------------------------------------------------

# - Concurrent session and pool size -

num_init_children = 80

max_pool = 4

# - Life time -

child_life_time = 300

child_max_connections = 0

connection_life_time = 0

client_idle_limit = 0

#------------------------------------------------------------------------------

# LOGS

#------------------------------------------------------------------------------

# - Where to log -

log_destination = 'syslog'

# - What to log -

log_line_prefix = '%t: pid %p: '

log_connections = on

log_hostname = off

log_statement = on

log_per_node_statement = on

log_client_messages = on

log_standby_delay = 'if_over_threshold'

# - Syslog specific -

syslog_facility = 'LOCAL0'

syslog_ident = 'pgpool'

# - Debug -

log_error_verbosity = default

#------------------------------------------------------------------------------

# FILE LOCATIONS

#------------------------------------------------------------------------------

pid_file_name = '/var/run/pgpool/pgpool.pid'

logdir = '/var/run/pgpool'

#------------------------------------------------------------------------------

# CONNECTION POOLING

#------------------------------------------------------------------------------

connection_cache = on

reset_query_list = 'ABORT; DISCARD ALL'

#------------------------------------------------------------------------------

# REPLICATION MODE

#------------------------------------------------------------------------------

replication_mode = off

replicate_select = off

insert_lock = off

lobj_lock_table = ''

# - Degenerate handling -

replication_stop_on_mismatch = off

failover_if_affected_tuples_mismatch = off

#------------------------------------------------------------------------------

# LOAD BALANCING MODE

#------------------------------------------------------------------------------

load_balance_mode = on

ignore_leading_white_space = on

white_function_list = ''

black_function_list = 'currval,lastval,nextval,setval'

black_query_pattern_list = ''

database_redirect_preference_list = ''

app_name_redirect_preference_list = ''

allow_sql_comments = off

disable_load_balance_on_write = 'transaction'

#------------------------------------------------------------------------------

# MASTER/SLAVE MODE

#------------------------------------------------------------------------------

master_slave_mode = on

master_slave_sub_mode = 'stream'

# - Streaming -

sr_check_period = 10

sr_check_user = 'postgres'

sr_check_password = 'password'

sr_check_database = 'postgres'

delay_threshold = 10000000

# - Special commands -

follow_master_command = ''

#------------------------------------------------------------------------------

# HEALTH CHECK GLOBAL PARAMETERS

#------------------------------------------------------------------------------

health_check_period = 5

health_check_timeout = 20

health_check_user = 'postgres'

health_check_password = 'password'

health_check_database = ''

health_check_max_retries = 0

health_check_retry_delay = 1

connect_timeout = 10000

#------------------------------------------------------------------------------

# FAILOVER AND FAILBACK

#------------------------------------------------------------------------------

failover_command = ''

failback_command = ''

failover_on_backend_error = on

detach_false_primary = off

search_primary_node_timeout = 300

#------------------------------------------------------------------------------

# ONLINE RECOVERY

#------------------------------------------------------------------------------

recovery_user = 'postgres'

recovery_password = 'password'

recovery_1st_stage_command = ''

recovery_2nd_stage_command = ''

recovery_timeout = 90

client_idle_limit_in_recovery = 0

#------------------------------------------------------------------------------

# WATCHDOG

#------------------------------------------------------------------------------

# - Enabling -

#use_watchdog = on

use_watchdog = off

# -Connection to up stream servers -

trusted_servers = ''

ping_path = '/bin'

# - Watchdog communication Settings -

wd_hostname = ''

wd_port = 9000

wd_priority = 1

wd_hostname = ''

wd_port = 9000

wd_priority = 2

wd_hostname = ''

wd_port = 9000

wd_priority = 3

wd_authkey = ''

wd_ipc_socket_dir = '/tmp'

# - Virtual IP control Setting -

delegate_IP = ''

if_cmd_path = '/sbin'

if_up_cmd = 'ip addr add $_IP_$/24 dev eth0 label eth0:0'

if_down_cmd = 'ip addr del $_IP_$/24 dev eth0'

arping_path = '/usr/sbin'

arping_cmd = 'arping -U $_IP_$ -w 1'

# - Behaivor on escalation Setting -

clear_memqcache_on_escalation = on

wd_escalation_command = ''

wd_de_escalation_command = ''

# - Watchdog consensus settings for failover -

failover_when_quorum_exists = on

failover_require_consensus = on

allow_multiple_failover_requests_from_node = off

# - Lifecheck Setting -

# -- common --

wd_monitoring_interfaces_list = ''

wd_lifecheck_method = 'heartbeat'

wd_interval = 10

# -- heartbeat mode --

wd_heartbeat_port = 9694

wd_heartbeat_keepalive = 2

wd_heartbeat_deadtime = 30

heartbeat_destination0 = 'host_ip1'

heartbeat_destination_port0 = 9694

heartbeat_device0 = ''

other_pgpool_hostname0 = 'host_ip1'

other_pgpool_port0 = 5432

other_wd_port0 = 9000

# -- query mode --

wd_life_point = 3

wd_lifecheck_query = 'SELECT 1'

wd_lifecheck_dbname = 'template1'

wd_lifecheck_user = 'nobody'

wd_lifecheck_password = ''

#------------------------------------------------------------------------------

# OTHERS

#------------------------------------------------------------------------------

relcache_expire = 0

relcache_size = 256

check_temp_table = on

check_unlogged_table = on

#------------------------------------------------------------------------------

# IN MEMORY QUERY MEMORY CACHE

#------------------------------------------------------------------------------

memory_cache_enabled = off

memqcache_method = 'shmem'

memqcache_memcached_host = 'localhost'

memqcache_memcached_port = 11211

memqcache_total_size = 67108864

memqcache_max_num_cache = 1000000

memqcache_expire = 0

memqcache_auto_cache_invalidation = on

memqcache_maxcache = 409600

memqcache_cache_block_size = 1048576

memqcache_oiddir = '/var/log/pgpool/oiddir'

white_memqcache_table_list = ''

black_memqcache_table_list = ''

Perhatikan pada bagian Backend Connection Setting pada file konfigurasi di atas kita set weight=1. Ini artinya kita berusaha agar perbandingan beban dari masing-masing backend adalah sama.

Selanjutnya ada 1 file lagi yang harus kita lengkapi yaitu /etc/pgpool-II/pool_passwd. Isilah file ini dengan username dan password yang sama dengan user postgresql. Entry dari file ini pool_passwd ini harus dibuat dengan menjalankan

pg_md5 -f /etc/pgpool-II/pgpool.conf -m -u postgres postgrespassword

Terakhir jalankan service pgpool

sudo systemctl start pgpool-II.service

sudo systemctl enable pgpool-II.service

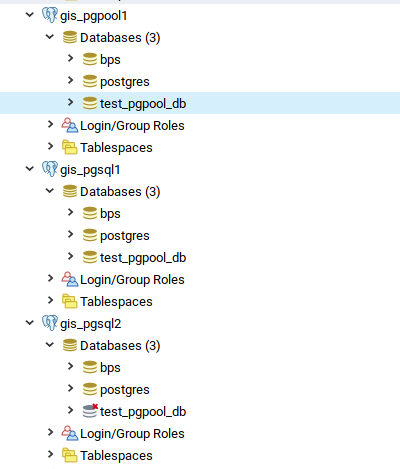

Kita bisa mencoba bagaimana pgpool bekerja dengan mentest membuat database dan menghapusnya melalui pgadmin. Kita koneksikan pgadmin kita ke server pgpool (masukkan ip address dan port mesin pgpool, username dan password pgpool), buat database maka database akan terbentuk di master dan slave. Hapus database melalui pgpool maka database akan terhapus di master dan slave.

Koneksi ke database dari aplikasi kita tinggal diarahkan ke mesin pgpool (tidak lagi ke mesin postgresql). Dengan cara demikian, proses WRITE akan dilakukan oleh pgpool ke mesin master, sedangkan proses READ akan dibagi ke mesin master dan slave. Untuk membuktikannya anda dapat menjalankan htop di setiap mesin postgresql dan lihat distribusi bebannya. Bisa juga dengan membandingkan log dari pgpool untuk melihat proses INSERT, UPDATE, SELECT dilakukan ke mesin mana saja. Misalnya dengan menjalankan

sudo journalctl -u pgpool-II | grep "node id: 0" | grep INSERT

sudo journalctl -u pgpool-II | grep "node id: 1" | grep INSERT

sudo journalctl -u pgpool-II | grep "node id: 2" | grep INSERT

sudo journalctl -u pgpool-II | grep "node id: 0" | grep SELECT

sudo journalctl -u pgpool-II | grep "node id: 1" | grep SELECT

sudo journalctl -u pgpool-II | grep "node id: 2" | grep SELECT

Masih ada yang belum ditulis dalam artikel ini yaitu bagaimana membuat mesin pgpool menjadi HA juga. Mudah-mudahan kedepannya dapat saya tuliskan.

Selamat mencoba, have fun

medwinz

#MozTalk – Open Source Day (openSUSE and Mozilla Firefox Edition)

Apakah kamu salah satu pengguna software open source yang ingin berkontribusi kembali ke proyeknya?

Pada kesempatan MozTalk kali ini kami akan membahas tentang cara berkontribusi ke proyek open source seperti openSUSE dan Mozilla Firefox. Akan ada 2 pembicara pada acara ini:

- Kukuh Syafaat

“Berkenalan (lagi) dengan openSUSE”

Ngobrol mengenai teknologi, komunitas dan kontribusi di openSUSE - Herpiko Dwi Aguno

“Ngoprek Mozilla Firefox”

Siklus kontribusi kode di Mozilla Firefox dari ujung ke ujung

MozTalk adalah salah satu program Mozilla Indonesia berupa sesi diskusi bertemakan teknologi dan perkembangannya. Untuk mengikuti acara ini, peserta diharapkan untuk memiliki ketertarikan untuk berkontribusi ke proyek open source

Simpan tanggal berikut untuk ikut acara ini ya:

Hari / Tanggal: Minggu / 19 Januari 2020

Pukul : 14.00 – 17.00

Tempat: Mozilla Community Space Jakarta, Gedung TIFA – ANNEX Suite Jl. Kuningan Barat I no.26 Jakarta Selatan (Google Map: https://goo.gl/maps/mjZZGmxdQzC2 )

Perlu kami beritahukan, acara ini gratis dan tidak berbayar, dan kami tidak akan menyediakan makan siang, namun tersedia berbagai minuman dan snack/kue yang dapat dikonsumsi secara gratis oleh peserta secara/free flow/

Pendaftaran: bit.ly/OSDayJakarta

Sampai berjumpa!

Mencoba Podman dan Buildah di openSUSE Tumbleweed

Podman

Apa itu Podman? Podman adalah mesin kontainer tanpa daemon untuk mengembangkan, mengelola, dan menjalankan container OCI di GNU/Linux. Kontainer dapat dijalankan sebagai root atau dalam mode tanpa root.Sederhananya: `alias docker=podman`.

Podman dapat mengelola seluruh ekosistem container yang mencakup pod, container, container image, dan volume menggunakan pustaka libpod. Podman dapat menjalankan semua perintah dan fungsi yang membantu memelihara dan memodifikasi container image OCI, seperti menarik dan memberi tag. Ini memungkinkan untuk membuat, menjalankan, dan memelihara container yang dibuat dari image dalam lingkungan produksi.

Memasang Podman

sudo zypper in slirp4netns podman

Menjalankan Podman Tanpa Akses Root

sudo bash -c 'echo 10000 > /proc/sys/user/max_user_namespaces'

sudo bash -c "echo $(whoami):100000:65536 > /etc/subuid"

sudo bash -c "echo $(whoami):100000:65536 > /etc/subgid"

Ujicoba Podman

podman pull nginx:stable

podman run --name nginx nginx:stable

podman rm nginx

Podman Cheat Sheet

podman login docker.io

podman search tuanpembual

podman run docker.io/tuanpembual/hello

podman run --rm --name hello -p 8080:80/tcp docker.io/tuanpembual/hello

podman rm hello

Sampe batas ini, ya memang benar kita bisa dengan entengnya membuat

alias docker=podman

di file .zshrc.

Buildah

Buildah – a tool that facilitates building OCI container images.

Buildah adalah tool buat bikin container images, dengan beberapa fitur yang menawan, diantaranya:

- Tidak ada Daemon. Jadi kalo mau build image ya tinggal build aja.

- Buat image dari nol(scratch) atau dari image yang sudah jadi.

- Merupakan Build tools external, sehingga memiliki karakter;Ukuran image lebih kecil,Membuat lebih aman dengan tidak memasukkan software untuk membuat container (like gcc, make, and dnf), Membutuhkan resource yang lebih kecil untuk mengirim images.

Memasang Buildah

sudo zypper in buildah

Membuat image dengan Buildah dari Dockerfile

# ls

Dockerfile myecho

# cat Dockerfile

FROM registry.access.redhat.com/ubi8/ubi

ADD myecho /usr/local/bin

ENTRYPOINT "/usr/local/bin/myecho"

# cat myecho

echo "This container works!"

# chmod 755 myecho

# ./myecho

This container works!

Build Step

# buildah bud -t tuanpembual/myecho .

STEP 1: FROM registry.redhat.io/ubi8/ubi

STEP 2: ADD myecho /usr/local/bin

STEP 3: ENTRYPOINT "/usr/local/bin/myecho"

Docker Format dan Push Image

buildah bud --format=docker -t docker.io/tuanpembual/myecho .

buildah push docker.io/tuanpembual/myecho

Melihat List images

buildah images

podman images

Menjalankan Container dan Memeriksa Container

podman run --rm tuanpembual/myecho

buildah inspect tuanpembual/myecho | less

Dah itu saja dulu. Ngoprek selanjutnya bagaimana menggunakan dua perkakas ini ke Gitlab-CI.

Estu~

High Availability PostgreSQL Cluster dengan Pgpool-II (Bagian ke-2)

TL;DR: Karena cukup panjang tulisan akan dibagi dalam 3 bagian

- Bagian 1 : membahas instalasi dan konfigurasi master postgresql

- Bagian 2 : membahas instalasi dan konfigurasi slave postgresql

- Bagian 3 : membahas instalasi dan konfigurasi pgpool-II

Tulisan ini adalah Bagian ke-2.

3. Instalasi PostgreSQL slave node

Instal PostgreSQL di mesin anda (instal di dua mesin slave, jika saat ini anda hanya punya satu mesin slave tidak mengapa)

sudo zypper ar -e -f https://download.opensuse.org/repositories/server:/database:/postgresql/openSUSE_Leap_15.1/ postgresql

sudo zypper in --no-recommends postgresql postgresql-server postgresql-contrib postgresql12-pgpool-II postgresql12 postgresql12-server postgresql12-contrib

Pastikan bahwa instalasi anda bekerja, service postgresql dapat berjalan.

sudo systemctl start postgresql.service

sudo systemctl enable postgresql.service

sudo systemctl status postgresql.servie

Pastikan bahwa tidak ada error. Selanjutnya matikan service postgresql.

sudo systemctl stop postgresql.service

Kemudian masuk ke mesin slave, hapuslah directory /var/lib/pgsql/data

rm -rf /var/lib/pgsql/data

selanjutnya jalankan

pg_basebackup -h ip_address_master -p 5432 -U nama_user_replication -v -D /var/lib/pgsql/data -Fp -Xs -P -R

Kalau sukses maka akan muncul seperti:

Setelah proses di atas selesai maka direktori /var/lib/pgsql/data akan terbentuk dan berisi:

Ada sebuah berkas penting yang terbentuk di direktori data pada slave setelah menjalankan pg_basebackup yaitu file standby.signal. File ini musti ada dalam direktori tersebut sehingga postgres dapat menentukan bahwa status server adalah slave/standby. File ini terbentuk otomatis saat menjalankan pg_basebackup dengan opsi “-R”. Jika tidak terbentuk maka buatlah file tersebut secara manual

touch standby.signal

Hal ini berhubungan dengan replication slot yang telah dibicarakan di atas. Pada PostgreSQL 12 akan terbentuk 2 file secara otomatis postgresql.auto.conf dan standby.signal. File postgresql.auto.conf secara otomatis berisi

# Do not edit this file manually!

# It will be overwritten by the ALTER SYSTEM command.

primary_conninfo = 'user=nama_user_replikasi password=password_user_replikasi host=ip_address_master port=port_master sslmode=prefer sslcompression=0 gssencmode=prefer krbsrvname=postgres target_session_attrs=any'

Sedangkan penanda bahwa server adalah standby/slave adalah file standby.signal

Untuk PostgreSQL 11 ke bawah maka ada versi di mana postgresql.auto.conf terbentuk tetapi tidak ada isinya. Sehingga secara manual harus dibuat file recovery.conf yang berisi seperti:

standby_mode = 'on'

primary_conninfo = 'user=nama_user-replikasi password=password_user_replikasi host=ip_address_master port=port_master sslmode=prefer sslcompression=0 gssencmode=prefer krbsrvname=postgres target_session_attrs=any'

Sedangkan file standby.signal tidak terbentuk, dan sebagai gantinya diganti dengan baris standby_mode = ‘on’ pada file recovery.conf.

Jika kita yakin bahwa database sudah tereplikasi dan direktori data sudah terbentuk dengan baik maka tambahkan konfigurasi postgresql.conf di slave dengan 2 baris ini:

hot_standby = on

hot_standby_feedback = on

hot_standby berfungsi untuk memberi tahu server bahwa server hanya digunakan untuk query read-only (load balancing).

hot_standby_feedback berfungsi untuk mencegah baris-baris data dihapus terlalu cepat dari sisi slave. Hal ini dilakukan dengan memberi tahu server master ID transaksi yang terlama sehingga proses vacuum menunda penghapusan baris tertentu. Penjelasan mengenai vacuum dapat dibaca di sini.

Selanjutnya aktifkan postgresql di mesin slave:

sudo systemctl start postgresql.service

sudo systemctl enable postgresql.service

Memeriksa status replikasi

Untuik memastikan bahwa replikasi antara master dan slave sudah berjalan sempurna maka login ke server master dan jalankan

sudo -i -u postgres

psql -x -c "select * from pg_stat_replication"

Jika sukses maka akan memperlihatkan status replikasi, misalnya

atau jika menggunakan pgadmin misalnya:

Coba juga misalnya dengan membuat database baru di master. Harusnya langsung terbentuk pula di slave

Master

Slave

Bersambung ke Bagian ke-3.

Have fun,

medwinz

High Availability Postgresql Cluster dengan Pgpool-II (Bagian ke-1)

TL;DR: Karena cukup panjang tulisan akan dibagi dalam 3 bagian

- Bagian 1 : membahas instalasi dan konfigurasi master postgresql

- Bagian 2 : membahas instalasi dan konfigurasi slave postgresql

- Bagian 3 : membahas instalasi dan konfigurasi pgpool-II

Tulisan ini adalah Bagian ke-1.

Sebagai pengguna postgresql kadang kita membutuhkan cluster database baik karena pertimbangan HA maupun karena pertimbangan pembagian beban (load balancing). Sayangnya postgresql hanya memiliki implementasi native untuk replikasi tetapi tidak untuk cluster. Sehingga untuk membangun cluster harus menggunakan aplikasi lain. Ada banyak solusi untuk membuat cluster di postgresql dan yang dijelaskan di sini adalah Pgpool-II.

Tulisan ini membahas konfigurasi postgresql cluster (master-slave load balancing). Penjelasan singkatnya:

- Postgresql dipasang di 3 mesin, 1 master dan 2 slave

- Pgpool dipasang di 1 mesin terpisah.

- Replikasi diserahkan kepada postgresql

- Pgpool akan mengatur load balancing, proses tulis/write (insert, update, delete, dll) akan dilakukan di master sedangkan proses baca/read (select, dll) akan dibagi 3, ke master dan ke-2 slave.

Desain logikal adalah sbb:

Dalam contoh ini dibutuhkan 4 mesin, walaupun bisa saja pgpool dipasang pada mesin master. Pgpool tidak membutuhkan resource yang besar dan tugasnya adalah mendistribusikan beban ke setiap mesin postgresql. Dengan cara demikian postgresql terasa jauh lebih ringan kerjanya dibanding jika kita memiliki 1 mesin postgresql dengan jumlah CPU dan RAM yang sama dengan gabungan 3 mesin postgresql yang bekerja secara load balance.

1. Instalasi openSUSE

Siapkan mesin. Untuk implementasi server biasanya saya menggunakan openSUSE Jeos dari http://download.opensuse.org/distribution/leap/15.1/jeos/ atau openstack image dari http://download.opensuse.org/repositories/Cloud:/Images:/Leap_15.1/images/

Tentu saja anda tetap bisa menggunakan image DVD seperti biasa dan menginstall minimum server. Silakan dipilih yang sesuai dengan kondisi anda. Dalam implementasi tulisan ini digunakan 1 mesin untuk pgpool dan 3 mesin untuk postgresql.

Sebagai catatan postgresql bekerja mengandalkan CPU karena itu tuninglah instalasi kernel openSUSE dan konfigurasi postgresql anda. Postgresql.conf harus dituning sesuai dengan kondisi mesin dan implementasinya. Untuk implementasi standar seperti untuk blog, website sederhana atau aplikasi kecil yang transaksinya tidak besar, menggunakan konfigurasi bawaan postgresql.conf sudah memadai, tetapi untuk aplikasi yang membutuhkan kinerja database yang optimum, konfigurasi postgresql.conf harus disesuaikan. Bagaimana melakukan tuning postgresql dan kernel silakan dibaca di sini. Pgpool karena hanya bekerja sebagai proxy cukup hemat dalam penggunaan CPU dan RAM. Sebagai gambaran saya menggunakan postgresql yang saat ini besaran datanya sekitar 15 juta baris, dengan penambahan data sekitar 100 ribu baris perhari. Data kami di-backup per hari, dan setiap sebulan sekali data berumur di atas 6 bulan diarsip. Masing-masing VM postgresql memiliki 4 vCPU dan 4GB RAM. Kondisi beban 100% sekitar 50% dari waktu sisanya dibawah 70%.

2. Instalasi PostgreSQL master node

Tambah repositori, install postgresql

sudo zypper ar -e -f https://download.opensuse.org/repositories/server:/database:/postgresql/openSUSE_Leap_15.1/ postgresql

sudo zypper in --no-recommends postgresql12-pgpool-II postgresql12 postgresql12-server postgresql12-contrib

Di contoh ini saya menggunakan postgresql12, sekiranya anda ingin menggunakan versi yang lain silakan diganti. Di repo postgresql tersedia versi 9.4, 9.5, 9.6, 10, 11 dan 12.

Selanjutnya jalankan service postgresql, secara otomotasi postgresql akan menginisiasi database dan membentuk direktori /var/lib/pgsql/data

sudo systemctl start postgresql.service

sudo systemctl enable postgresql.service

Silakan login ke postgresql, tambahkan user baru dan beri privilege sebagai replicator. Menggunakan user postgres tidak dianjurkan.

postgres=# CREATE USER nama_user WITH REPLICATION ENCRYPTED PASSWORD 'rahasia';

postgres=# \du

Kalau anda sudah punya instalasi postgresql dan sudah ada user, cukup tambahkan role saja

postgres=# ALTER ROLE nama_user Replication;

Jangan lupa user tersebut diberi pula role/privilege untuk mengakses database sesuai aplikasi anda (ya iyalah).

Streaming replication di postgresql bekerja melalui pengiriman log dari master ke slave. Setiap transaksi ditulis dalam log transaksi yang dinamakan WAL (write-ahead log). Slave menggunakan segmen WAL ini untuk secara kontinu mereplikasi setiap perubahan dari master.

Untuk menjalankan streaming replication postgresql melakukannya melalui 3 proses utama, wal sender, wal receiver dan startup.

Proses wal sender berjalan di master sedangkan wal receiver dan startup berjalan di slave. Ketika replikasi dimulai, proses wal receiver mengirimkan LSN (Log Sequence Number) menjelaskan status sampai WAL data mana telah di-reply oleh slave ke master. Kemudian prose wal sender akan mengirimkan WAL data ke slave sesuai dengan status terakhir LSN yang dikirimkan oleh wal receiver. wal receiver selanjutnya menulis data tersebut ke WAL segments di mesin slave. Proses startup di slave kemudian me-reply ke master bahwa data mulai ditulis ke WAL segment sebagai tanda dimulainya replikasi

Berdasarkan pengalaman saya, di bawah ini beberapa parameter konfigurasi postgresql yang wajib dipahami untuk membuat replikasi database. YMMV, silakan baca-baca dokumentasi postgresql untuk pemahaman lebih lanjut.

- archive_mode : Kalau anda ingin untuk mengarsip WAL anda musti menset ke ON (saya tidak menggunakannya karena pertimbangan disk saja, karena sudah menggunakan 2 slave dan melakukan backup harian).

- wal_level : diset ke replica kalau versi postgresql di atas 9.5, versi 9.5 ke bawah set ke hot_standby.

- max_wal_senders : sebagai acuan untuk satu buah slave di set ke 3, setiap penambahan slave ditambah 2.

- wal_keep_segments : jumlah WAL yang dipertahankan di direktori pg_wal (postgresql 10 ke atas) atau pg_xlog (sampai PostgreSQL 9.x). Setiap WAL file/segmen berukuran 16 MB. Bisa dimulai dengan 100, artinya anda membutuhkan sekitar 1.6GB disk.

- max_wal_size dan min_wal_size : parameter ini akan menimpa konfigurasi max_wal_senders. Jadi kalau anda menset max_wal_senders = 100, tetapi max_wal_size = 2GB maka wal segmen akan terus diisi sampai ukuran direktori 2GB. Saya menggunakan ini dan menset max_wal_size = 2 GB dan min_wal_size = 1 GB

- archive_command : Jika anda ingin mengarsip/mengcopy WAL segment ke tempat lain maka anda bisa menjalankan shell/bash command atau program lain dengan parameter ini.Saya juga tidak menggunakannya karena alasan yang sama dengan archive_mode di atas.

- listen_addresses : tetapkan IP address atau gunakan ‘*’.

- hot_standby : set ke ON pada slave (standby/replica), pada master tidak berefek apa-apa. Ini adalah parameter koentji, tanpa menset ke ON slave tidak dapat melakukan query READ (baca: SELECT).

Lakukan pengaturan untuk parameter-parameter di atas pada file /var/lib/pgsql/data/postgresql.conf. Sebagai contoh, konfigurasi yang digunakan adalah sebagai berikut:

listen_addresses = '*'

port = 5432

max_connections = 30

shared_buffers = 512MB

huge_pages = on

work_mem = 8738kB

maintenance_work_mem = 256MB

dynamic_shared_memory_type = posix

effective_io_concurrency = 300

max_worker_processes = 4

max_parallel_workers_per_gather = 2

max_parallel_workers = 4

wal_level = replica

wal_buffers = 16MB

min_wal_size = 1GB

max_wal_size = 2GB

checkpoint_completion_target = 0.9

max_wal_senders = 10

wal_keep_segments = 64

max_replication_slots = 4

enable_partitionwise_join = on

enable_partitionwise_aggregate = on

seq_page_cost = 1.0

random_page_cost = 4.0

effective_cache_size = 2048MB

default_statistics_target = 100

shared_preload_libraries = 'pg_stat_statements'

track_activity_query_size = 2048

pg_stat_statements.track = all

log_destination = 'stderr'

logging_collector = on

log_line_prefix = '%m %d %u [%p]'

log_timezone = 'UTC'

datestyle = 'iso, mdy'

timezone = 'UTC'

lc_messages = 'en_US.UTF-8'

lc_monetary = 'en_US.UTF-8'

lc_numeric = 'en_US.UTF-8'

lc_time = 'en_US.UTF-8'

default_text_search_config = 'pg_catalog.english'

Sebenarnya konfigurasi di atas sudah disesuaikan dengan implementasi aplikasi saya. Ada beberapa parameter seperti pengaturan memory/cache/buffer/huge pages yang harusnya diset khusus sesuai implementasi dan kondisi mesin. Silakan baca kembali tulisan sebelumnya mengenai cara mentuning konfigurasi postgresql di sini.

Langkah berikutnya adalah memberikan hak akses untuk mesin slave agar dapat melakukan replikasi ke master. Lakukan pengaturan pada file /var/lib/pgsql/data/pg_hba.conf. Tambahkan seperti di bawah dan sesuaikan ip mesin slave anda:

host replication replication 10.100.1.7/32 md5

host replication replication 10.100.1.8/32 md5

Replication Slots

Replication slots merupakan catatan permanen dari kondisi sebuah replika yang disimpan di master server walaupun kondisi replika sedang offline atau terputus. pg_replication_slots view akan memberikan daftar replication slots yang ada pada kondisi tertentu di database cluster beserta statusnya.

Replication slots merupakan pendekatan baru: di mana mengizinkan server master mengetahui kondisi setiap slave dan status replikasinya, serta menjaga WAL selama dibutuhkan. Dengan cara ini server master pada dasarnya akan menahan WAL file selamanya, menunggu server slave/standby untuk mengambilnya. Secara teoritis kita dapat menyalakan server slave/standby setelah mati berminggu-minggu, dan secara otomatis akan mengcopy WAL dan membuat datanya menjadi sama tanpa perlu intervensi dari kita.

Cara membuat replication slot adalah dengan login ke master postgresql dan jalankan

SELECT * FROM pg_create_physical_replication_slot('nama_slot');

nama_slot bisa diisi dengan nama server slave anda, dan buatlah slot sebanyak jumlah slave anda. Jika sudah anda dapat memeriksanya, misalnya:

Periksa ulang postgresql.conf anda dan pastikan 3 baris di bawah sudah ada:

wal_level = replica

max_replication_slots = 4

max_wal_senders = 20

wal_level bisa diisi hot_standby jika memang anda menginginkan slave hanya standby dan akan mengambil-alih database jika master tidak berfungsi, atau replica dimana slave juga bekerja (dalam hal ini kita akan mengalihkan query READ ke slave)

max-replication adalah jumlah maksimum slot replikasi (slave server)

max_wal_senders adalah jumlah maksimum proses WAL sender yang berjalan bersamaan dari slave server, default = 10.

Lanjutkan dengan restart postgresql.service di master

sudo systemctl restart postgresql.service

Catatan:

Untuk anda yang menyimpan direktori data di NAS/SAN atau koneksi isci lain (remote disk) perlu memodifikasi script systemd untuk postgresql.service. Ada beberapa laporan bahwa postgresql.service tidak dapat jalan otomatis setelah reboot. Jika anda mengalami masalah ini, modifikasi script /usr/lib/systemd/system/postgresql.service menjadi:

[Unit]

Description=PostgreSQL database server

After=syslog.target

After=network.target remote-fs.target data\xxxx.mount dev-hugepages.mount

[Service]

Type=forking

User=postgres

EnvironmentFile=-/etc/sysconfig/postgresql

LimitMEMLOCK=infinity

ExecStart=/usr/share/postgresql/postgresql-script start

ExecStop=/usr/share/postgresql/postgresql-script stop

ExecReload=/usr/share/postgresql/postgresql-script reload

# The server might be slow to stop, and that's fine. Don't kill it

SendSIGKILL=no

[Install]

WantedBy=multi-user.target

Perhatikan bagian ini

After=network.target remote-fs.target data\xxxx.mount dev-hugepages.mount

Aslinya hanya After=network.target

Kemudian karena pada implementasi seringkali $PG_DATA itu diletakkan di iscsi disk maka harus dipastikan bahwa iscsi disk sudah di-mount dan remote-fs sudah terbentuk sebelum postgresql dijalankan. Hal ini bisa dicek dengan perintah di bawah dan tambahkan dari hasilnya ke dalam start-up script yang menurut anda logis.

systemctl list-units --type=mount

systemctl list-units --type=target

Bersambung ke Bagian ke-2

Have fun,

medwinz

Memasang JDownloader di openSUSE Leap 15.1

Bagi yang terbiasa mengunduh file menggunakan download manager, mungkin banyak pilihan download manager yang dapat digunakan baik melalui ekstensi browser maupun melalui tools di konsole/terminal linux, beberapa alasan saya menggunakan download manager adalah agar dapat melakukan pause dan resume pada file yang di unduh.

pada tulisan ini saya akan memberikan sedikit panduan untuk memasang download manager berbaskasih komentar dan saranyais desktop yaitu JDownlader. JDownloader sendiri adalah tools download manager berbasis open source yang dapat di pasang di banyak platform salah satunya di Linux openSUSE, oke langsung saja buka konsole/terminal dan ketik perintah berikut

wget -c http://installer.jdownloader.org/JD2Setup_x64.sh

kemudian berikan executable pada file

chmod +x JD2Setup_x64.sh

lanjutkan proses pemasangan dengan mengetik perintah berikut

sh JD2Setup_x64.sh

dan lanjutkan intruksi yang tertera di layar

setelah selsai dapat langsung digunakan, jangan lupa untuk di integerasikan dengan ekstensi browser yang di pakai.

apabila ada kendala silahkan berikan komentar dan sarannya, sekian dan terimakasih.

Podman dan Buildah di openSUSE Tumbleweed

Ini cuma ulasan pendek di sela-sela kegalauan turing nyepeda.

Masih mengingat beberapa pe-er komunitas, bareng Ish Sookun untuk mengerjakan beberapa tulisan terkait Kubic, dan turunannya. Belum sempat nyolek lagi. Saya mencoba menulis catatan kecil tentang mainan di akhir tahun. Ini sebenarnya merupakan catatan lama, namun tersisih di mesin berbeda.

Balik ke tema, saya sedang coba-coba menggunakan container daemon selain docker.

Podman

What is Podman? Podman is a daemonless container engine for developing, managing, and running OCI Containers on your Linux System. Containers can either be run as root or in rootless mode. Simply put:

alias docker=podman.Containers under the control of Podman can either be run by root or by a non-privileged user. Podman manages the entire container ecosystem which includes pods, containers, container images, and container volumes using the libpod library. Podman specializes in all of the commands and functions that help you to maintain and modify OCI container images, such as pulling and tagging. It allows you to create, run, and maintain those containers created from those images in a production environment.

podman.io

Kira-kira begitu pengertiannya.

Persiapan Lab

Saya mencoba podman di minipc saya dan di laptop dalam vagrant. Step-step berikut saya lakukan dalam vagrant. Berikut Vagrantfile saya:

Vagrant.configure("2") do |config|

config.vm.box = "opensuse/Tumbleweed.x86_64"

config.vm.box_version = "1.0.20191231"

config.vm.define :podman do |podman|

podman.vm.host_name="podman"

podman.vm.network "private_network", ip: "192.168.33.99", bridge: "wlan0"

podman.vm.provider "virtualbox" do |vb|

vb.memory = "1024"

end

end

end

Lanjut dengan vagrant up dan vagrant ssh. Akan login sebagai user vagrant

Bacaan Podman

Memasang Podman

sudo zypper in slirp4netns podman

Rootless

sudo bash -c 'echo 10000 > /proc/sys/user/max_user_namespaces'

sudo bash -c "echo $(whoami):100000:65536 > /etc/subuid"

sudo bash -c "echo $(whoami):100000:65536 > /etc/subgid"

Menjalankan Podman

FYI: ubi=Red Hat universal base image

podman pull registry.access.redhat.com/ubi8/ubi

podman run --name redhat registry.access.redhat.com/ubi8/ubi cat /etc/os-release

podman rm redhat

Podman Cheat Sheet

podman login docker.io

podman search tuanpembual

podman run docker.io/tuanpembual/hello

podman run --rm --name hello -p 8080:80/tcp docker.io/tuanpembual/hello

podman rm hello

Sampe batas ini, ya memang benar kita bisa dengan entengnya membuat alias docker=podman.

Buildah

Bacaan Buildah

Buildah – a tool that facilitates building OCI container images.

Buildah.io

Buildah adalah tool buat bikin container images, dengan beberapa fitur yang menawan, diantaranya:

- Tidak ada Daemon. Jadi kalo mau build image ya tinggal build aja.

- Buat image dari nol(scratch) atau dari image yang sudah jadi.

- Merupakan Build tools external, sehingga memiliki karakter:

- Ukuran image lebih kecil

- Membuat lebih aman dengan tidak memasukkan software untuk membuat container (like gcc, make, and dnf) within the resulting image.

- Membutuhkan resource yang lebih kecil untuk mengirim images.

Buildah is able to operate without Docker or other container runtimes by storing data separately and by including features that let you not only build images, but run those images as containers as well. By default, Buildah stores images in an area identified as containers-storage (/var/lib/containers).

Buildah.io

Kira kira gitu pengantar teorinya.

Memasang Buildah

sudo zypper in buildah

Membuat image dengan Buildah dari Dockerfile

# ls

Dockerfile myecho

# cat Dockerfile

FROM registry.access.redhat.com/ubi8/ubi

ADD myecho /usr/local/bin

ENTRYPOINT "/usr/local/bin/myecho"

# cat myecho

echo "This container works!"

# chmod 755 myecho

# ./myecho

This container works!

Build Step:

# buildah bud -t tuanpembual/myecho .

STEP 1: FROM registry.redhat.io/ubi8/ubi

STEP 2: ADD myecho /usr/local/bin

STEP 3: ENTRYPOINT "/usr/local/bin/myecho"

Docker format and push

buildah bud --format=docker -t docker.io/tuanpembual/myecho .

buildah push docker.io/tuanpembual/myecho

List images:

buildah images

podman images

Running dan Inspect Images

podman run --rm tuanpembual/myecho

buildah inspect tuanpembual/myecho | less

Dah itu saja dulu. Ngoprek selanjutnya bagaimana menggunakan dua perkakas ini ke Gitlab-CI.

Estu~

estu

estu