#openSUSE Tumbleweed revisión de la semana 4 de 2020

Tumbleweed es una distribución “Rolling Release” de actualización contínua. Aquí puedes estar al tanto de las últimas novedades.

openSUSE Tumbleweed es la versión “rolling release” o de actualización continua de la distribución de GNU/Linux openSUSE.

Hagamos un repaso a las novedades que han llegado hasta los repositorios esta semana

El anuncio original lo puedes leer en el blog de Dominique Leuenberger, publicado bajo licencia CC-by-sa, en este enlace:

Durante esta cuarta semana del año 2020 se ha publicado cinco snapshots y esto teniendo en cuenta que se han descartado 2 por problemas en los tests QA.

El test openQA ha salvado a los usuarios de que les fallase chromium dentro de una sesión de KDE/Wayland por ejmplo. Estas cincon snapshots fueron: 0116, 0117, 0118, 0121 y 0122.

Las actualizaciones más importantes que han traido son:The releases contained these updates:

- Mesa 19.3.2

- systemd 244

- Dracut 049+git118: el servicio de eliminación de kernels ha sido eliminado en favor de un paquete separado, basado en comandos de zypper. Ese servicio todavía no está habilitado (la llamada de zypper interactua negativamente con los complementos de notificaciones de PackageKit, pero se están preparando los parches para esto)

- Linux kernel 5.4.12 y 5.4.13

- Qt 5.14.0

- Poppler 0.84.0

Y entre las actualizaciones que llegarán pronto a los repositorios de openSUSE Tumbleweed, se puede destacar:

- Python 3.8

- Eliminación de python 2

- gettext 0.20.1

- libcap 2.30:

- GNU make 4.3

- KDE Plasma 5.18 (actualmente se está testeando la versión Beta)

- Linux kernel 5.4.14+

Si quieres estar a la última con software actualizado y probado utiliza openSUSE Tumbleweed la opción rolling release de la distribución de GNU/Linux openSUSE.

Mantente actualizado y ya sabes: Have a lot of fun!!

Enlaces de interés

-

-

- ¿Por qué deberías utilizar openSUSE Tumbleweed?

- zypper dup en Tumbleweed hace todo el trabajo al actualizar

- ¿Cual es el mejor comando para actualizar Tumbleweed?

- Comprueba la valoración de las “snapshots” de Tumbleweed

- ¿Qué es el test openQA?

- http://download.opensuse.org/tumbleweed/iso/

- https://es.opensuse.org/Portal:Tumbleweed

-

——————————–

Cómo borrar en #Vim texto dentro de comillas, paréntesis, corchetes, etc…

Vamos a aprender a borrar rápidamente texto “encerrado” entre comillas, paréntesis, corchetes u otros delimitadores utilizando el editor de texto Vim

Quizás editando código o un texto, necesitamos borrar texto que está dentro de unas comillas o un paréntesis o unos corchetes o llaves o comillas simples. Veamos cómo realizar esa operación rápidamente gracias a la potencia del editor vim y sus comandos.

Este artículo forma parte de la serie de artículos sobre Vim que vengo realizando desde hace meses con aquello que voy descubriendo o aprendiendo y que puedes seguir en este enlace:

Si tenemos un texto dentro de unas comillas que queremos borrar, con el editor vim es muy sencillo decirle que borre todo lo que hay dentro de las comillas, mediante la combinación de teclas:

di"

Diseccionando el comando, encontramos:

- d → delete o acción que queremos hacer, en este caso borrar

- i → inside o donde lo queremos hacer, en este caso dentro

- ” → delimitador de lo que queremos borrar, en este caso las comillas

Con esto nos borraría el texto que se encuentra dentro de las comillas, de las primeras comillas que encuentre desde la posición del cursor en adelante. Nos borra el texto y posiciona el cursor dentro de las comillas, por si queremos escribir algo.

También podemos decirle que borre, no solo el texto, si no también las propias comillas, para eso en vez de decirle inside le diríamos around

da(

Con este comando nos borraría lo que hay dentro de los paréntesis y los propios paréntesis (lo mismo para otros delimitadores).

A diferencia de las comillas, con los paréntesis, corchetes y llaves, vim borrará aquellas donde el cursor este dentro. Si hay varios anidados, borrará los paréntesis donde el cursor se encuentre.

Pero no solo podemos borrar, podemos utilizar otras acciones que nos ofrece Vim. Así por ejemplo podemos cambiar el texto dentro de unos corchetes por otro, mediante

ci[

Con esto Vim borrará el texto dentro de los corchetes y se pondrá en modo edición para poderlo cambiar por lo que deseemos.

¿Conocías esto? Seguro que ves el potencial que tiene!! Tienes un ejemplo práctico en el siguiente vídeo:

Recopilación del boletín de noticias de la Free Software Foundation – enero de 2020

Boletín de noticias relacionadas con el software libre publicado por la Free Software Foundation.

¡El boletín de noticias de la FSF está aquí!

La Free Software Foundation (FSF) es una organización creada en Octubre de 1985 por Richard Stallman y otros entusiastas del software libre con el propósito de difundir esta filosofía.

La Fundación para el software libre (FSF) se dedica a eliminar las restricciones sobre la copia, redistribución, entendimiento, y modificación de programas de computadoras. Con este objeto, promociona el desarrollo y uso del software libre en todas las áreas de la computación, pero muy particularmente, ayudando a desarrollar el sistema operativo GNU.

Además de tratar de difundir la filosofía del software libre, y de crear licencias que permitan la difusión de obras y conservando los derechos de autorías, también llevan a cabo diversas campañas de concienciación y para proteger derechos de los usuarios frentes a aquellos que quieren poner restricciones abusivas en cuestiones tecnológicas.

Mensualmente publican un boletín (supporter) con noticias relacionadas con el software libre, sus campañas, o eventos. Una forma de difundir los proyectos, para que la gente conozca los hechos, se haga su propia opinión, y tomen partido si creen que la reivindicación es justa!!

- En este enlace podéis leer el original en inglés: https://www.fsf.org/free-software-supporter/2020/january

- Y traducido en español en este enlace: https://www.fsf.org/free-software-supporter/2020/enero

Puedes ver todos los números publicados en este enlace: http://www.fsf.org/free-software-supporter/free-software-supporter

Después de muchos años colaborando en la traducción al español del boletín, desde inicios de este año 2020 he decidido tomarme un descanso en esta tarea.

Pero hay detrás un pequeño grupo de personas que siguen haciendo posible la difusión en español del boletín de noticias de la FSF.

¿Te gustaría aportar tu ayuda en la traducción? Lee el siguiente enlace:

Por aquí te traigo un extracto de algunas de las noticias que ha destacado la FSF este mes de enero de 2020

La FSF no puede hacer campaña a favor del software libre sin tu ayuda

El equipo de campañas de la Free Software Foundation (FSF) trabaja incansablemente para difundir el mensaje al mundo de que todo el software debe ser libre. Hacer campañas por el software libre requiere creatividad, trabajo duro y una comunidad dedicada.

Ampliamos las organizaciones de software libre y los proyectos, movilizamos a los activistas y proporcionamos recursos. Sólo somos tres personas, pero somos el punto de conexión para cientos de miles de partidarios anualmente. Tienes el poder de aumentar exponencialmente este número. Es nuestro objetivo hacer de la conversación sobre el software libre un tema de la mesa de cocina, ¡y necesitamos tu ayuda!

Para el año 2020, estamos ampliando nuestra oferta del regalo exclusivo a todos los asociados nuevos o que renueven su afiliación anual hasta el 17 de enero.

Por favor, ayúdanos a alcanzar nuestra meta de 600 nuevos miembros comenzando el nuevo año con una nueva membresía de la FSF.

¡comparte nuestras imágenes promocionales

para iniciar conversaciones sobre el software libre, y anima a tus amigos

y familiares a unirse!

- https://www.fsf.org/blogs/community/the-fsf-cant-campaign-for-free-software-without-your-help

- https://www.fsf.org/blogs/community/last-chance-to-help-us-reach-our-membership-goal-in-2019

Presentación de: ShoeTool — Felices Fiestas de la FSF

Del 23 de diciembre

ShoeTool es un cuento de hadas animado sobre un elfo zapatero que cree que compra una máquina para ayudarle a hacer zapatos… sólo para descubrir que hay cadenas que atan su “compra”.

¡Por favor, muestra tu apoyo al software libre y a este vídeo promocionándolo en tus redes sociales usando la etiqueta #shoetool!

Las restricciones de software, análogas al tipo de restricciones con las que nuestro protagonista Wendell se encuentra como usuario de la prometedora ShoeTool, son perjudiciales para nuestra libertad, creatividad y trabajos.

Esperamos que ver las frustraciones de Wendell despierte a muchos hogares

y ayude a más gente a entenderlo.

- https://www.fsf.org/blogs/community/presenting-shoetool-happy-holidays-from-the-fsf

- https://victorhckinthefreeworld.com/2019/12/25/debemos-liberar-la-tecnologia-si-queremos-ser-libres-shoetool/

El equipo técnico de la FSF: Haciendo más por el software libre

Del 4 de diciembre

El equipo técnico de la Free Software Foundation (FSF) trabaja diariamente para mantener y mejorar la infraestructura que soporta cientos de proyectos de software libre, junto con la propia FSF, en su misión de crear un mundo donde todo el software respete nuestra libertad y dignidad.

No subcontratamos ninguna de nuestras necesidades diarias de software porque necesitamos estar seguros de que se hacen usando sólo software libre. Recuerda, no hay “nube”, sólo ordenadores de otras personas.

Por ejemplo: no subcontratamos nuestro correo electrónico, así que cada día enviamos más de medio millón de mensajes a miles de hackers de software libre a través de las listas de correo de la comunidad que alojamos. Tampoco subcontratamos nuestro almacenamiento web o redes, por lo que servimos decenas de miles de descargas de software libre – más de 1,5 terabytes de datos – al día.

Y nuestra popularidad, y la naturaleza crítica de los recursos que ponemos a disposición, nos convierten en un blanco para los ataques de denegación de servicio (uno de ellos está en curso mientras escribimos esto), lo que requiere una supervisión constante por parte del equipo técnico, cuyos miembros se turnan para estar listos para el trabajo de emergencia, de modo que los recursos de los que dependen nuestros partidarios permanezcan disponibles.

Replicant necesita tu ayuda para liberar a Android en el 2020

Del 10 de diciembre

La Free Software Foundation (FSF) apoya el trabajo de varios proyectos importantes de software libre a través del patrocinio fiscal en un programa que llamamos Trabajando Juntos por el Software Libre.

Debido a la omnipresencia del uso de teléfonos móviles en la vida moderna, la liberación de estos pequeños ordenadores es una tarea importante, por lo que es tan crucial apoyar el proyecto Replicant, un sistema operativo móvil de software libre que hace hincapié en la libertad, la privacidad y la seguridad.

Estas son solo algunas de las noticias recogidas este mes, pero hay muchas más muy interesantes!! si quieres leerlas todas visita este enlace:

Y todos los números del “supporter” o boletín de noticias de 2020 aquí:

—————————————————————

Elecciones para el Consejo de #openSUSE. La comunidad decide

En este mes de enero de 2020 la comunidad de openSUSE vuelve a decidir sobre quien quiere que ocupe los puestos vacantes en el Consejo de openSUSE

Desde el pasado día 16 de enero de 2020 y hasta el próximo 31 de enero de 2020 las personas que forman la comunidad de openSUSE tienen el poder para decidir quien formará parte del Consejo de openSUSE.

Las fases previas de presentación de candidaturas y presentación de los candidatos finales ya han llegado a su fin. Ahora toca el tiempo de votar y decidir.

Para los 2 puestos vacantes al Consejo de openSUSE, se han presentado 4 candidaturas:

Ahora los miembros de la comunidad de openSUSE tienen el poder de decidir qué personas de esos candidatos ocuparán los 2 puestos vacantes.

A los miembros de openSUSE se les supone suscritos a listas de correo de esta comunidad que desarrolla y mantiene esta distribución de GNU/Linux, por lo que ya les sonarán los nombres de algunos de los candidatos.

Esas 4 personas que se han presentado al cargo han desarrollado tareas en mayor o menor medida para la comunidad de openSUSE como responsables de paquetes, encargándose de la infraestructura o en otros proyectos relacionados con openSUSE.

Las personas elegidas se unirían al Consejo de openSUSE, formado por 5 miembros de la comunidad elegidos por la comunidad y un presidente escogido por SUSE.

Antes del periodo de votación las personas que se presentan al cargo ya han expresado sus intereses y lo que pretenden impulsar o realizar desde su cargo si son elegidas.

Entre las tareas de este consejo no están el dirigir por uno u otro lado el rumbo del desarrollo de la distribución, o tomar decisiones, el consejo de openSUSE está para mediar, para tomar decisiones en cuestiones en las que los grupos de trabajo no se pongan de acuerdo, etc

Precisando más, estas son las tareas del Consejo de openSUSE:

- Actuar como un punto central de contacto

- Ayuda a resolver conflictos

- Comunicar los intereses de la comunidad a SUSE

- Facilitar la comunicación con todas las áreas de la comunidad

- Facilitar los procesos de toma de decisiones donde sea necesario

- Iniciar discusiones sobre nuevas iniciativas para todo el proyecto

Solo los miembros de la comunidad de openSUSE tienen derecho a voto. Si ya eres miembro, habrás recibido un correo a tu “alias” de correo de openSUSE con las credenciales para votar.

Es hora de expresar tu decisión. ¡Quizás en una próxima ocasión te decidas tu mismo/a a ser protagonista de otras elecciones!

Casa Hacienda Buena Vista, en Lurín

Xfce 4.14 ya disponible en Tumbleweed

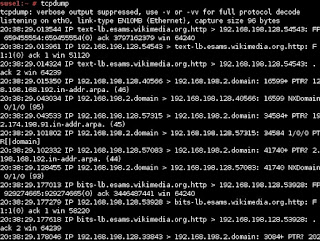

Diagnóstica tu red con Tcpdump

Apolo XI – 50 Aniversario

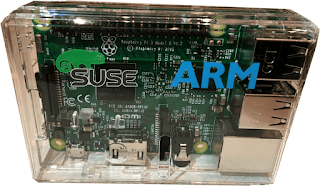

openSUSE Leap 15.1 ofrece la experiencia completa de Linux en Raspberry Pi

openSUSE ofrece además dos versiones: Leap sigue el modelo de versión fija y Tumbleweed sigue el modelo de versión móvil. En este artículo, les contaré sobre la última versión estable de openSUSE Leap 15.1 basada en SUSE Linux Enterprise 15 Service Pack 1.

Comenzando con el entorno de escritorio, Leap 15.1 nos permite elegir múltiples entornos de escritorio como KDE, GNOME y Xfce. Las opciones específicas disponibles con Leap 15.1 son KDE Plasma 15.2 y GNOME 3.26.

La distro también se envía con una pila de gráficos completamente nueva. Sin embargo, la nueva versión aún funciona con el kernel de Linux 4.12 pero contiene el muy necesario backporting de 4.19. También obtiene un mejor soporte para las CPUs AMD Vega y otro hardware.

Para mejorar la experiencia en 4K (HiDPI), Leap 15.1 ahora los detectará y escalará el escritorio para brindar una experiencia visual nítida. Para los audiófilos, hay mejoras como el audio HD de alta definición y otras actualizaciones como los controladores de audio USB con puerto trasero.

openSUSE Leap 15.1 para ARM64, es el primer sistema operativo multipropósito que te permite disfrutar de una experiencia de escritorio Linux estándar completa en Raspberry Pi. Así que, ¿qué significa? esto significa que la imagen ISO estándar de Leap se puede instalar directamente en la Pi; no se necesita ninguna imagen personalizada. El instalador Leap detecta el Pi, aplica las configuraciones predefinidas y continúa con la instalación.

Los desarrolladores han aconsejado a los usuarios de openSUSE Leap 15.0 que se actualicen a Leap 15.1, ya que el ciclo de soporte de la versión 15.0 expirará en los próximos 6 meses. Para aquellos que no lo saben, las versiones menores de Leap 15 reciben 18 meses de soporte.

Para aquellos que estén interesados en realizar una instalación limpia, los archivos ISO y torrent se pueden encontrar aquí. Pruébalo y comparte tus experiencias. ¡Diviertete mucho!

Labplot-Aplicación de análisis y visualización de datos

- Gestión de datos basada en proyectos.

- Project-explorer para la gestión y organización de objetos creados en diferentes carpetas y subcarpetas.

- Hoja de cálculo con funcionalidad básica para el ingreso manual de datos o para la generación de números aleatorios uniformes y no uniformes.

- Importación de datos ASCII externos en el proyecto para su posterior edición y visualización.

- Exportación de hoja de cálculo a un archivo ASCII.

- La hoja de trabajo como principal objeto principal para gráficos, etiquetas, etc., admite diferentes diseños y funciones de zoom.

- Exportación de la hoja de trabajo a diferentes formatos (pdf, eps, png y svg).

- Gran variedad de capacidades de edición para las propiedades de la hoja de cálculo y sus objetos.

- Gráficos cartesianos, creados a partir de conjuntos de datos importados o creados manualmente o mediante ecuación matemática.

- La definición de fórmulas matemáticas se apoya en el resaltado y finalización de la sintaxis y en la lista de constantes y funciones matemáticas y físicas agrupadas temáticamente.

- El análisis de los datos trazados es compatible con muchas funciones de zoom y navegación.

- Ajustes lineales y no lineales a los datos, se predefinen varios modelos de ajuste y se pueden proporcionar modelos personalizados con un número arbitrario de parámetros

Para instalar LabPlot en openSUSE accedemos a la siguiente URL:

https://software.opensuse.org/package/labplot-kf5

y seleccionamos la versión de openSUSE que estemos utilizando (Leap, Tumbleweed) con la tecnología 1 Click Install y seguimos las instrucciones de instalación.

#HaveALotOfFun #DivierteteMucho

Member

Member Victorhck

Victorhck