openSUSE.Asia Summit 2025: Call for Host

The openSUSE.Asia Summit is an annual openSUSE conference in Asia and a great opportunity for contributors and enthusiasts from Asia to come together and meet face-to-face. The event focuses primarily on the openSUSE distribution, its applications for personal and enterprise use, and open source culture.

In its quest to spread openSUSE throughout Asia, openSUSE.Asia Summit Organization Committee seeks out local communities to rise to the challenge of organizing an excellent openSUSE event in 2025. The committee stands ready to assist you throughout the process.

Here is the date you need to take notes:

- Oct. 1: Deadline for application

- Nov. 3: Presentation at openSUSE.Asia Summit 2024

- Dec. 23: Announcement of the following host

We will invite you to our regular online meetings so that you can experience and learn how to organize the event. Furthermore, we will ask you to present your proposals at the next summit in Tokyo, Japan.

The submitted proposals are to be reviewed by the organization committee. During the review, the committee might have additional questions and requests.

How to Submit?

Please email your proposal to both summit@lists.opensuse.org and opensuseasia-summit@googlegroups.com. Because the former address does not allow attachments, you need to upload your proposal somewhere and share the link to it.

The proposal should contain:

- Venue

- How to reach your city and venue

- Budget Estimation

- Conference Venue

- T-shirt

- Tea break, Lunch, Dinner, Conference Tour, etc.

- Introduction to your community who will organize the summit

Please refer to openSUSE.Asia Summit Tips for Organizers before writing your proposal.

We are looking forward to hearing from you soon!

Primera actualización de Plasma 6.1

Me alegra compartir con todos vosotros la primera actualización de Plasma 6.1, iniciando así una serie de revisión de software que le dotará de más estabilidad, mejores traducción y resolución de errores. Estas actualizaciones son 100% recomendables y casi obligatorias para cualquier usuario ya que lo único que hacen es mejorar la versión sin comprometer sus funcionalidades.

Primera actualización de Plasma 6.1

No existe Software creado por la humanidad que no contenga errores. Es un hecho incontestable y cuya única solución son las actualizaciones. Es por ello que en el ciclo de desarrollo del software creado por la Comunidad KDE se incluye siempre las fechas de las mismas siguiendo una especie de serie de Fibonacci.

La Comunidad KDE ha publicado se se ha lanzado la primera actualización de Plasma 6.1, una versión que viene a subsanar los errores más graves del gran salto en cuanto a tecnología que fue Plasma 6.

Así que me congratula en presentar que hoy martes 25 de junio de 2024, una semana después de liberar el código de Plasma 6.1 la Comunidad KDE presenta la primera actualización de errores.

Más información: KDE

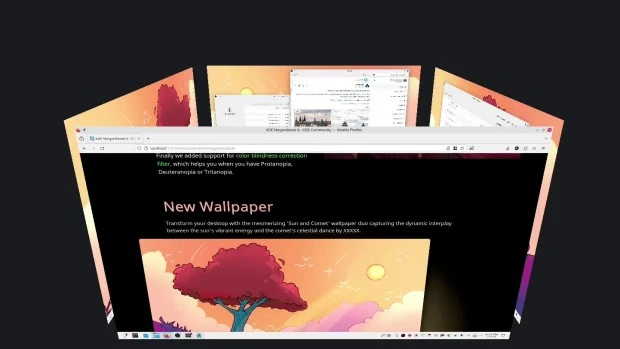

Las novedades básicas del Plasma 6.1

Hoy es un día de de descarga y actualizaciones, y mientras espero que esté disponible para mi KDE Neon, os comento algunas de sus novedades:

No obstante, aquí tenéis unas pinceladas de las novedades que nos facilitaron los desarrolladores en su fase beta fueron las siguientes:

- Triple búfer en KWin para una mejor renderización y animaciones más fluidas.

- Permitir el uso del protocolo de sincronización explícita de Wayland, lo que debería mejorar la vida de los usuarios de NVIDIA en particular.

- Permitir el uso del portal de captura de entrada.

- Integración del sistema de escritorio remoto para permitir conexiones de clientes RDP con el escritorio Plasma, además de una nueva página en las «Preferencias del sistema» para configurarla.

- Nueva experiencia de usuario para el modo de edición de Plasma, para hacer que su modalidad sea más obvia y visualmente más elegante.

- Se ha añadido una barrera de borde configurable entre pantallas, para que sea más fácil alcanzar los elementos de la interfaz de usuario que tocan los bordes entre pantallas. Esto también permite que los paneles que se ocultan automáticamente en los bordes entre las pantallas funcionen correctamente.

- Restauración de falsa sesión en Wayland que, por lo menos, vuelve a abrir las aplicaciones que estaban abiertas la última vez, incluso aunque no vuelvan a estar situadas en el mismo lugar. Todavía se sigue trabajando en la restauración real de la sesión.

- Compatibilidad con la sincronización del color de la luz RGB posterior del teclado con el color de acento de Plasma.

- Permitir el uso del perfil de color integrado en la pantalla, para las pantallas que lo incluyan.

- Permitir que Discover pueda sustituir aplicaciones Flatpak que han alcanzado el final de soporte con sus reemplazos.

- Compatibilidad con las funciones del modo de conservación de batería en muchos portátiles Lenovo IdeaPad y Legion.

- Compatibilidad con el bloqueo de pantalla sin contraseña, que permite usarlo como un salvapantallas en entornos sin problemas de seguridad.

- Ahora se puede hacer un clic central en el widget de «Energía y batería» para bloquear o desbloquear el reposo automático y el bloqueo de la pantalla. También se puede usar la rueda del ratón sobre él para cambiar el perfil de ahorro de energía activo.

- Esquinas ligeramente redondeadas y más coherencia entre los radios de las esquinas en todas partes.

- Mejor algoritmo de organización de ventanas para la «Vista general».

- El efecto «Mover el cursor para encontrarlo» se ha activado de forma predeterminada.

- Nuevo efecto desactivado de forma predeterminada para ocultar el puntero del ratón tras un período de inactividad.

- La página del teclado de las «Preferencias del sistema» se ha reescrito en QML.

En los próximas entradas más detalles.

Y esto es una brevísima pincelada… Creo que ahora tengo temas de para el blog de sobra hasta 2025.

La entrada Primera actualización de Plasma 6.1 se publicó primero en KDE Blog.

Leap Micro 6.0 is now available. Leap Micro 5.4 reaches End of Life.

A new major version of Leap Micro is now available! Leap Micro 6.0 images can be found at get.opensuse.org.

Leap Micro 6.0 uses a brand-new codebase, comes with plenty of new appliances and, for the first time, enters images for public cloud.

About Leap Micro

Leap Micro 6.0 is a rebranded SUSE Linux Enterprise Micro 6.0 which is an ultra-reliable container and Virtual Machine host by SUSE. Leap Micro is released twice a year and has support over two releases.

Leap Micro 5.4 is now EOL

With the release of Leap Micro 6.0, Leap Micro 5.4 reaches End Of Life; users will no longer receive maintenance updates and are advised to upgrade.

More conservative users can stay on Leap Micro 5.5, which will receive updates until the release of Leap Micro 6.1.

Understanding Image variants

All of Leap and SLE Micro generally come in two variants either Base or Default.

Both Base and Default have a container stack, but only the Default variant has the Virtual Machine stack.

If you do not plan to use VMs and you care for space, then the Base might be a variant just for you.

All of our images offered at get-o-o are the Default ones (VMs+containers) as we expect they’re suitable for most users.

All appliances including Base variants (without virtualization stack) can be downloaded directly from https://download.opensuse.org/distribution/leap-micro/6.0/appliances/

Explaining individual appliances

A general recommendation for everyone use is the self-install image. It’s a bootable image with a quick wizard that writes the preconfigured image to your drive and grows the root partition. This process from boot takes about 5 minutes.

The preconfigured image is a raw bootable image you can manually write/dd to the disk or SD card. Images can be configured via Ignition/Combustion or will default to the jeos-firsboot wizard.

We have a Real-time image with kernel-rt, qcow image for KVM, VMWare image, and a brand new raw image with Full Disk Encryption.

Users who want to try our FDE image within a VM will need to make sure that they’re using emulated tpm-2 chip and UEFI. This can be achieved easily with virt-manager.

SLE Micro 6.0 dropped the traditional installer in favor of self-install media, therefore Leap Micro 6.0 doesn’t have it either.

The new Packages image is not a bootable media. This is just an image with an offline repository in case you need it.

Leap Micro 6.0 comes for the first time also with Public Cloud Images.

Images will soon be available with all major public cloud providers.

Upgrading from 5.X

A recommendation is to make a clean install since this is a brand-new major version.

For those who’d like to try migration, please follow the upgrade guide.

Release Notes

Users can refer to SLE Micro 6.0 Release notes.

Leap Micro 6.0 uses openSUSE-repos for repository management. It is highly recommended to pay attention to this detail, especially for those who migrate. Here is an article explaining how openSUSE repos work.

Leap Micro 6.0 has no longer a dedicated SLE update repo. This has been merged into the main repository.

KCD Italy - CEL, Kubernetes ValidatingAdmissionPolicy and Kubewarden

Last week I had the opportunity to speak at KCD Italy, a Kubernetes Community Days event. I delivered a talk titled “How to leverage and extend CEL for your cluster security”. The talk gives an overview about the Common Expression Language (CEL), Kubernetes ValidatingAdmissionPolicy, and Kubewarden.

While the talk has been delivered in Italian, the slides are in English and can be found here.

IA rodando em computador antigo de R$ 600,00

O governo recentemente declarou que a Inteligência Artificial (IA) não está ao alcance de todos, uma afirmação que reflete a obsolescência programada no mercado de tecnologia. No entanto, estou comprometido em assegurar que essa visão não se torne uma realidade, especialmente ao abordar o desafio contínuo da exclusão digital. Uma das principais barreiras é a obsolescência programada, que frequentemente restringe o uso de tecnologias modernas em computadores mais antigos. Assim, estou dedicando esforços para desenvolver soluções que contrariem essa tendência, permitindo que mais pessoas tenham acesso a ferramentas tecnológicas atualizadas sem a necessidade de equipamentos de última geração.

Na prática, isso se traduziu no desenvolvimento da imagem JAX Linux, que foi especialmente otimizada para melhorar o desempenho em máquinas mais antigas e novas. Utilizando técnicas avançadas como a extensão de vetorização, conseguimos fazer com que modelos de IA avançados, como o Mistral 7B, funcionem eficientemente em um computador i5 de 2016 com apenas 8GB de RAM e sem uma GPU de alta performance. Esse tipo de otimização é crucial para democratizar o acesso à IA, permitindo que mesmo hardware com especificações modestas possa executar tarefas computacionais intensivas sem comprometer significativamente a performance.

Os resultados desse projeto são notavelmente promissores, com testes mostrando que o uso máximo de recursos de hardware não ultrapassou 60%. Isso demonstra que é perfeitamente viável levar a inteligência artificial para indivíduos com recursos financeiros limitados. Essa conquista não apenas desafia a norma atual que associa a inovação em IA com equipamentos de ponta, mas também reforça o compromisso de tornar a tecnologia acessível para todos, independentemente de suas condições econômicas. Através desses esforços, estamos um passo mais perto de uma verdadeira democratização da inteligência artificial.

Las novedades de Kdenlive en KDE Gear 24.05

Siguiendo el objetivo de mostrar qué ofreció el pasado mayo la Comunidad KDE en cuanto a aplicaciones. Así que ya he hablado de las nueva aplicaciones del ecosistema, de Dolphin, de Itinerary, de Neochat y de Tokodon. Así que hoy toca hablar de las novedades de Kdenlive en KDE Gear 24.05, el editor de vídeo no lineal de KDE.

Las novedades de Kdenlive en KDE Gear 24.05

Aunque es de sobra conocido en el mundillo nunca está de más presentar las aplicaciones, Kdenlive es el completo editor de vídeo de KDE que nos proporciona todo lo necesario para crear anuncios, documentales, programas de TV y películas de calidad. Inicialmente ofrecía mucha potencia pero tenía bastantes problemas de estabilidad, desde hace unos años, estos problemas han desaparecido (Casi todos) y se está convirtiendo en otra Killer APP dentro de las aplicaciones Libres. Solo diré que mis compañeros profesores la utilizan sin apenas formación para realizar los típicos vídeos de final de curso.

Esta nueva versión 24.05 incorpora efectos de grupo, que se pueden añadir a videoclips agrupados. También puede llegar a audiencias más amplias usando IA sin conexión que puede traducir los subtítulos con la función de traducción automáticas de subtítulos.

Por otra parte, ha vuelto la función que permitía capturar sonido desde el escritorio o con un micrófono directamente desde Kdenlive. También se ha mejorado notablemente el rendimiento al mover videoclips con la herramienta del espaciador.

Para finalizar destacar quela función de gestión de múltiples contenedores de recursos (los contenedores son las áreas donde se guardan los videoclips, las imágenes, los títulos y las animaciones) también se ha revisado y mejorado.

Más información: KDE Gear 24.05

La entrada Las novedades de Kdenlive en KDE Gear 24.05 se publicó primero en KDE Blog.

Zellij la alternativa a Tmux como multiplexador de tu terminal

Tiene la funcionalidad básica de un multiplexor de terminal (similar a tmux o screen) pero incluye muchas funciones integradas

Desde hace unos días estoy probando Zellij, un software publicado bajo licencia MIT, que permite crear espacios de trabajo a la hora de trabajar con la terminal en sistemas GNU/Linux.

Es un software similar a otros multiplexadores de terminal, más veteranos y conocidos como son Tmux o screen sobre los que he escrito artículos en el blog.

Zellij ofrece una información e interfaz más visual al alcance del usuario, por lo que puede facilitar su uso e incluye muchas funciones integradas que permiten a los usuarios ampliarlo y crear su propio entorno personalizado.

Instalando

Lo primero será instalarlo en nuestra distribución de GNU/Linux, buscándolo en los repositorios. En openSUSE Tumbleweed vale ejecutar un simple zypper in zellij para tenerlo en nuestro equipo.

Una vez instalado, abrimos una terminal y ejecutamos zellij y se nos abrirá un marco con una pestaña, e información de los atajos de teclado disponibles en la parte inferior.

Comenzando

Con zellij, podremos crear diferentes espacios de trabajo, si hacemos un uso intensivo de la terminal o simplemente siempre tenemos varias cosas corriendo en la terminal al mismo tiempo.

Podremos dividir el espacio de trabajo de manera sencilla en diferentes pestañas, de manera similar a un navegador y estas a su vez en paneles con divisiones verticales u horizontales, e incluso paneles flotantes (como ves en la captura que abre el artículo).

Zellij incluye un motor de diseño que permite a los usuarios definir una disposición de cómo queremos los paneles en un archivo de configuración y cargarlo cuando inician la aplicación. De esta manera, uno puede tener los paneles dispuestos de la manera que quiera sin tener que hacer todo el trabajo de configuración.

Paneles

Pero para empezar a usarlo, echando un vistazo a la parte inferior, vemos que con Ctrl+P y después n dividiremos el espacio actual en otro panel. Podemos cambiar entre los paneles con Alt+flechas de cursores

Podemos asignarles diferentes nombres a esos paneles mediante Ctrl+P y después c y escribiremos el nombre que queramos que aparecerá en la parte superior izquierda del panel.

Pestañas

Al igual que en paneles, podemos dividir el espacio en pestañas mediante Ctrl+T y después n Y también podremos asignarle un nombre diferente a las pestañas mediante Ctrl+T y después r

Los paneles que hayamos creado, los podremos redimensionar mediante Ctrl+n y diversas maneras de hacerlo, bien con el +,- o con las flechas o usando las teclas de Vim hjkl.

Sesiones

De manera predeterminada al iniciar Zellij, nos abre una sesión que llama con nombres aleatorios y exóticos como: awesome-rustaceous

Las sesiones son diferentes espacios de trabajo. La ventaja que tienen las sesiones es que podemos loguearnos mediante ssh a una máquina remota o un servidor por ejemplo y podemos cerrar nuestra sesión de Zellij, y antes debemos «detach» la sesión y esa sesión quedará activa mediante Ctrl+o y con d

Por lo que podremos retomarla más adelante como si nunca ubiéramos dejado de estar conectados a la máquina remota. Podremos acceder al gestor de sesiones mediante Ctrl+o y después w Y desde ahí renombrar la sesión actual Ctrl+r. O con Tab crear una nueva sesión, o resucitar una sesión antigua que hemos tenido.

La verdad que es un software que puede ayudar mucho, y puede que aporte algo extra a tu forma de trabajar si ya lo hacías con Tmux, con la posibilidad de crear tus propios complementos en función de lo que necesites.

Enlaces de interés

openSUSE 15.4 to 15.5 upgrade notes

Las novedades de Tokodon en KDE Gear 24.05

Siguiendo el objetivo de mostrar qué ofreció el pasado mayo la Comunidad KDE en cuanto a aplicaciones. Hace unos días hablé de las nueva aplicaciones del ecosistema, después de Dolphin, posteriormente de Itinerary y ayer de Neochat. Hoy toca hablar de las novedades de Tokodon en KDE Gear 24.05, una plataforma para utilizar redes sociales como las de Mastodon.

Las novedades de Tokodon en KDE Gear 24.05

Tokodon es una de desa aplicaciones que ponen la plataforma de redes sociales federadas como Mastodon a tu alcance, con una integración fabulosa en el escritorio o dispositivo móvol.

Con Tokodon se puede leer, publicar y enviar mensajes fácilmente, y sus funcionalidades no paran de crecer para convertirse en un un cliente a la altura de los entornos de trabajo KDE. Las novedades más desatacadas de la versión 24.05 las siguientes:

Ahora, al escribir una nueva publicación, se puede hacer en una ventana separada, lo que le permite continuar usando Tokodon mientras se escribe la publicación.

Adicionalmente, se ha añadido una marca con un contador para seguir las solicitudes de seguimiento en la barra lateral.

Pequeñas mejoras pero constantes para que poco a poco se convierte en una aplicación imprescindible si utilizas esta red.

Más información: KDE Gear 24.05

La entrada Las novedades de Tokodon en KDE Gear 24.05 se publicó primero en KDE Blog.

Χτίζοντας μια Κοινότητα Ελεύθερου Λογισμικού: Η τεκμηρίωση

Με μεγάλη χαρά σας παρουσιάζω τη τεκμηρίωση με τίτλο "Χτίζοντας μια Κοινότητα Ελεύθερου Λογισμικού" (https://iosifidis.github.io/fosscommunities/). Στην τεκμηρίωση αυτή, περιγράφονται αναλυτικά οι τρόποι με τους οποίους μπορεί κάποιος να δημιουργήσει μια κοινότητα Ελεύθερου Λογισμικού και πώς να την λειτουργήσει αποτελεσματικά.

Η τεκμηρίωση αυτή αποτελεί το αποτέλεσμα γνώσεων και εμπειριών που αποκτήθηκαν από την ενασχόλησή μου με το Ελεύθερο Λογισμικό και τις κοινότητες ΕΛΛΑΚ από το 2006. Περιλαμβάνει πρακτικές συμβουλές, στρατηγικές και βέλτιστες πρακτικές που μπορούν να βοηθήσουν τόσο νέους όσο και έμπειρους χρήστες να οικοδομήσουν και να διαχειριστούν βιώσιμες και ενεργές κοινότητες.

Σημειώνεται ότι η τεκμηρίωση δεν καλύπτει όλες τις υπάρχουσες κοινότητες ΕΛΛΑΚ. Εάν ανήκετε σε μια κοινότητα που δεν έχει αναφερθεί και θέλετε να συμπεριληφθεί, παρακαλούμε να μου στείλετε πληροφορίες για να προστεθεί στην τεκμηρίωση. Η συμμετοχή σας είναι πολύτιμη για την πληρότητα και τη συνεχή βελτίωση του έργου.

Η νέα τεκμηρίωση είναι διαθέσιμη για όλους και ευελπιστώ ότι θα αποτελέσει ένα χρήσιμο εργαλείο για όσους επιθυμούν να συμβάλλουν στην ανάπτυξη και την υποστήριξη του Ελεύθερου Λογισμικού. Διαβάστε την και ξεκινήστε να χτίζετε τη δική σας κοινότητα σήμερα!

Για περισσότερες πληροφορίες μπορείτε να ανατρέξετε στην τεκμηρίωση https://iosifidis.github.io/fosscommunities/.

Member

Member baltolkien

baltolkien