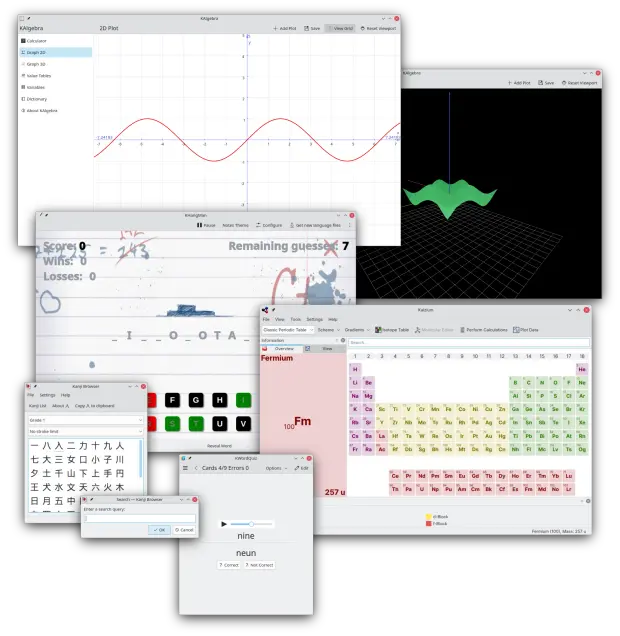

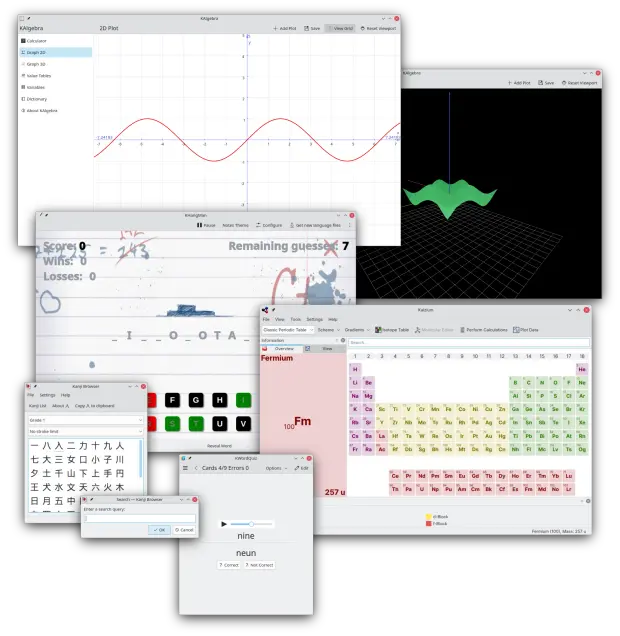

Primera actualización de KDE Gear 24.02

La Comunidad KDE es una comunidad responsable y no solo se preocupa en lanzar novedades sino que también en mejorarlas. Me complace presentar la primera actualización de KDE Gear 24.02 que apareció hace casi un mes. Más estabilidad, mejores traducciones y pequeñas mejoras para las aplicaciones de nuestro entornos de trabajo.

Primera actualización de KDE Gear 24.02

A pesar de lo que puedan pensar muchas personas, las aplicaciones no son perfectas. Entre las líneas de código se pueden colar errores de tipografía o que el usuario realice alguna opción que en un principio no estaba prevista por los desarrollador, por poner solo un par de ejemplos de imperfecciones.

Este no es un problema del Software Libre ya que el Software actual funciona de esta manera ya que no se piensa en él como un producto final que se encierra en una caja y se olvida. En la actualidad se sabe que el Software está vivo y sería estúpido ir guardando las mejoras sin dejarlas a disposición del gran público.

Con esto se gana en rapidez y evolución pero puede aumentar el número de errores (por norma general) leves, los cuales son subsanables con pequeñas actualizaciones.

La Comunidad KDE lo tiene claro: grandes lanzamientos cada cuatro meses y actualizaciones mensuales para subsanar errores.

Por ello me congratula compartir con vosotros la primera actualización de KDE Gear 24.02 que nos ofrece más de 180 errores resueltos entre aplicaciones, librerías y widgets, algo que mejora el rendimiento del sistema.

Aquí podéis encontrar la lista completa de cambios de KDE Gear 24.02.1, pero por poner unos cuantos ejemplos de los errores que sea han resuelto tenemos:

- Dolphin: No ocultaba los paneles tras minimizar.

- Konversation: Se ha corregido el cierre a la bandeja del sistema.

- Knights: Se ha corregido el cierre de la aplicación durante el final del juego.

Más información: KDE Gear 24.02.01

La entrada Primera actualización de KDE Gear 24.02 se publicó primero en KDE Blog.

LocalSend | Easily Share Files Between Nearby Devices

Preferencias del sistema han sido reorganizadas en Plasma 6

Seguimos con el repaso a las novedades de Plasma 6. En esta ocasión toca con un tema importante ya que, como ya se sabe, una de las características más destacadas del entorno gráfico de la Comunidad KDE es su alta capacidad de personalización, y eso se conigue con los System Settings. Para que esta herramienta fundamental siga mejorando ha recibido mucho trabajo y para este nuevo escritorio las Preferencia del sistema ha sido reorganizadas para dotarlas de mayor coherencias y facilidad de uso.

Preferencias del sistema han sido reorganizadas en Plasma 6

Encontrar que debo tocar para que mi escritorio tengas el aspecto, se comparte y utilice de forma eficiente mi hardware es fundamental. Es algo que sabe el equipo de diseño y los programadores de KDE y por ello llevan muchos meses trabajando y optimizando el uso de las Preferencias del Sistema.

Para esta nueva versión nos han ofrecido un lavado de cara considerable, cambiando de orden secciones enteras e introduciendo cambios como:

- Se ha mejorado la aplicación de Preferencias para que resulte más amigable y tenga menos páginas anidadas.

- En muchas páginas de preferencias se han reubicado los botones en la barra de herramientas, mejorando la consistencia con otras aplicaciones y creando espacio adicional para en contenido real.

- Ahora dispone de la opción de personalizar el tema de sonido. También se ha introducido un nuevo tema predeterminado de sonido llamado Océano, que sustituye al tema de sonido Oxígeno.

- Otra novedad es que ahora se pueden configurar con facilidad las aplicaciones preferidas para tipos de archivos generales, como los de música y vídeo.

Más información: KDE

Las novedades básicas del Plasma 6

A l largo de muchos días voy a ir desgranando las novedades de Plasma 6 pero es bueno tener una pequeña lista donde se reúnana las principales:

- Nuevo efecto de vista general: se han combinado los efectos de Vista general y Cuadrícula de escritorios en uno, con grandes mejoras en los gestos del panel táctil.

- Color mejorado: Plasma en Wayland ya tiene compatibilidad parcial con alto rango dinámico (HDR).

- Nuevo fondo de escritorio: Árbol escarlata, creado por axo1otl.

- Panel flotante: en Plasma 6, el panel flota de forma predeterminada. Se puede cambiar, por supuesto.

- ¡Nuevos valores predeterminados!

- Brisa refrescada: se ha rediseñado el tema Brisa para que presente un aspecto más moderno, con menos marcos y con un espaciado más consistente.

- Preferencias reorganizadas: se ha mejorado la aplicación de Preferencias para que resulte más amigable y tenga menos páginas anidadas.

- ¡El cubo ha vuelto!

- Mejoras en la búsqueda de Plasma: ahora personalizar el orden de los resultados de la búsqueda y es mucho más rápida.

- Mejoras en Plasma Mobile.

- Cambios en todas las aplicaciones de KDE Gear: Kontact, Kleopatras. Itineray, KDE Edu, KDEnlive, Dolphin, Spectacle, etc.

Y esto es una brevísima pincelada… Creo que ahora tengo temas de para el blog de sobra hasta 2025.

La entrada Preferencias del sistema han sido reorganizadas en Plasma 6 se publicó primero en KDE Blog.

Wall Mount Glasses Holder

Am Linuxrechner Bluetooth per USB nachrüsten

Ich brauchte kürzlich an meinem gut abgehangenen Desktop-Rechner dann doch mal die Möglichkeit meine Sony-Kopfhörer per Bluetooth zu verbinden. Da Bluetooth vor 10 Jahren allerdings für Hauptplatinen von normalen Rechnern noch nicht üblich war, hat mein Rechner kein Bluetooth. Ich habe deshalb jetzt, ohne große Recherche und nur von der spontanen Verfügbarkeit getrieben, einen BT-8500 von Edimax gekauft. In den USB-Port eingesteckt poppte im KDE sofort das Bluetooth-Applet auf und ich könnte die Kopfhörer verbinden. Die Verbindung zu den Kopfhörer ist auch richtig stabil, mindestens genau so gut wie vom Fairphone.

Wie gut der Adapter für andere Szenarien geeignet ist kann ich nicht sagen. Aber wer sich fragt ob ein Edimax BT-8500 unter openSUSE Leap 15.5 für Bluetooth-Audio funktioniert: das geht komplett ohne Bastelei.

KDE Plasma 6 ¡llegó! y RELUCE – Vídeo de Computadoras y Sensores

Seguimos con el repaso a las novedades de Plasma 6, aunque en esta ocasión mediante un vídeo de KDE Plasma 6 ¡llegó! y RELUCE como Entorno de Escritorio (Análisis en Arch) donde nos hacen un repaso detallado de algunas de las novedades principales.

KDE Plasma 6 ¡llegó! y RELUCE – Vídeo de Computadoras y Sensores

Poco tiempo en el día de hoy para poder publicar así que me he decidido en compartir un vídeo de Computadoras y Sensores donde en apenas 12 minutos nos revisan el nuevo escritorio de la Comunidad KDE.

Las novedades básicas del Plasma 6

A l largo de muchos días voy a ir desgranando las novedades de Plasma 6 pero es bueno tener una pequeña lista donde se reúnana las principales:

- Nuevo efecto de vista general: se han combinado los efectos de Vista general y Cuadrícula de escritorios en uno, con grandes mejoras en los gestos del panel táctil.

- Color mejorado: Plasma en Wayland ya tiene compatibilidad parcial con alto rango dinámico (HDR).

- Nuevo fondo de escritorio: Árbol escarlata, creado por axo1otl.

- Panel flotante: en Plasma 6, el panel flota de forma predeterminada. Se puede cambiar, por supuesto.

- ¡Nuevos valores predeterminados!

- Brisa refrescada: se ha rediseñado el tema Brisa para que presente un aspecto más moderno, con menos marcos y con un espaciado más consistente.

- Preferencias reorganizadas: se ha mejorado la aplicación de Preferencias para que resulte más amigable y tenga menos páginas anidadas.

- ¡El cubo ha vuelto!

- Mejoras en la búsqueda de Plasma: ahora personalizar el orden de los resultados de la búsqueda y es mucho más rápida.

- Mejoras en Plasma Mobile.

- Cambios en todas las aplicaciones de KDE Gear: Kontact, Kleopatras. Itineray, KDE Edu, KDEnlive, Dolphin, Spectacle, etc.

Y esto es una brevísima pincelada… Creo que ahora tengo temas de para el blog de sobra hasta 2025.

La entrada KDE Plasma 6 ¡llegó! y RELUCE – Vídeo de Computadoras y Sensores se publicó primero en KDE Blog.

openSUSE Tumbleweed – Review of the week 2024/12

Dear Tumbleweed users and hackers,

Here at openSUSE, we celebrated the ‘month of the desktops’. Both major desktop environments (KDE/Plasma and GNOME) just came out with their new releases in the last weeks and Tumbleweed users had the pleasure of receiving both those updates during the last few days. Not stopping there, we can look back at a full 7 snapshots (0314, 0315, 0317, 0318, 0319, 0320,and 0321) published since the last weekly review.

The most relevant changes shipped were:

- KDE Plasma 6.0.2

- Systemd 255.3 & 255.4

- Linux kernel 6.8.1 & Kernel firmware 20240312

- linux-glibc-devel 6.8 (kernel 6.8 headers)

- strace * iputils2 6.8

- QEmu 8.2.2

- LLVM 18

- SQLite 3.45.2

- GNOME 46.0

- PHP 8.2.17

- Qt 5.15.13

So, irrespective of KDE or GNOME user: enjoy the update. As usual, please report bugs – should you see any – to https://bugzilla.opensuse.org

The next few changes that are planned are:

- KDE Gear 24.02.1

- Shadow 4.15.0

- TeXLive 2024

- Removal of Python 3.9 modules: To successfully perform this, most – if not all – python-* packages should be fixed. Counterintuitively, removing a python flavor means we need to rebuild the packages (python-single spec) successfully

- dbus-broker: no progress this week

- libxml 2.12.x: slow/no progress

- GCC 14: phase 2: use gcc14 as the default compiler

QRencode | Generate QR Codes in the Terminal

Generate QR Codes in the Terminal with qrencode

Nueva versión de eXeLearning, tu editor de recursos educativos e interactivos

Me complace compartir con todos vosotros que ha sido lanzada una nueva versión de eXeLearning, eleditor de recursos educativos e interactivos que ofrece decenas de opciones para crear todo tipo de contenido, desde juegos a páginas webs o rúbricas de evaluación.

Nueva versión de eXeLearning, tu editor de recursos educativos e interactivos

Como podemos leer en la páginas del Cedec (Centro Nacional de Desarrollo Curricular en Sistemas No Propietarios) acaba de ser lanzada la versión 2.9 de eXeLearning, la herramienta de autor de software libre que permite que permite la creación y modificación de contenidos digitales interactivos de una manera sencilla.

Esta nueva versión incluye nuevos iDevices de juegos y de recogida de resultados, una barra de accesibilidad y otras mejoras y correcciones como:

-

Nuevos juegos:

- Clasifica: Permite crear juegos en los que el alumnado tendrá que clasificar tarjetas con imágenes, textos y/o sonidos en distintas categorías creadas previamente.

- Descubre: Permite crear juegos en los que los estudiantes tendrán que descubrir parejas, tríos o cuartetos de tarjetas con imágenes, textos y/o sonidos.

- Ordena: Permite crear juegos en los que el alumnado tendrá que ordenar, frases o tarjetas con imágenes, textos y/o sonidos.

- Relaciona: Permite crear juegos de relacionar conceptos uniéndolos con flechas. Pueden usarse imágenes, sonidos y textos enriquecidos.

- Selecciona (multimedia): Permite crear actividades interactivas en las que el alumnado tendrá que seleccionar las tarjetas multimedia correctas.

-

Nuevos idevices de recogida de resultados:

- Informe de progreso: permite mostrar los resultados obtenidos por el alumnado en las actividades asociadas al mismo, así como su nota media.

- Lista de cotejo: permite introducir una lista de cotejo para ofrecer un listado estructurado y fácil de entender de las actividades propuestas a lo largo del recurso educativo.

- Añadida la Barra de accesibilidad con la que el usuario podrá elegir entre la tipografía del estilo con el que se ha creado el material y otras tres: OpenDyslexic, Atkinson Hyperlegible y Montserrat. De igual forma, podrá aumentar o disminuir el tamaño de la letra o utilizar un botón para leer la pantalla o el texto seleccionado.

- Mejoras en la integración con Moodle para poder crear y editar contenidos de eXeLearning desde el propio Moodle de una forma sencilla y rápida.

Además, según los desarrolladores:

La publicación de la versión 2.9 de eXeLearning coincide con la liberación del código actual de eXeLearning online (también actualizado a la 2.9) y de los plugins de integración de eXeLearning con Moodle. Estos desarrollos funcionan desde hace tiempo en las plataformas educativas de Extremadura, y se implantaron recientemente en Madrid. Otras administraciones autonómicas se encuentran ya en proceso de instalación de la herramienta.

hora, se liberan para que cualquier usuario pueda utilizarlos, un paso importante en la historia del proyecto que nace de la colaboración de administraciones y usuarios.

Más información: CEDEC

¿Qué es eXeLearning

Para los que no lo conozcan, eXeLearning es un editor de recursos educativos e interactivos de código abierto se caracteriza por:

- Permite crear contenidos educativos de una manera sencilla

- Descarga fácil y gratuita desde su web.

- Está disponible para todos los sistemas operativos.

- Nos pemite catalogar los contenidos y publicarlos en diferentes formatos:

- Sitio web navegable y adaptable a diferentes dispositivos (responsive design).

- Estándar educativo, para trabajar con Moodle y otros LMS.

- Página HTML única para imprimir cómodamente tu trabajo.

- ePub3 (libro electrónico), etc.

- Ofrece diferentes diseños a elegir desde el menú, además de la posibilidad de crear diseños propios.

Con eXelearnig se puede crear todo tipo de actividades entre las que destaco rellenar huecos, pregunta de elección múltiple, pregunta de selección múltiple, pregunta verdadero-falso, cCuestionario SCORM o actividad desplegable.

Además, y este es uno de los principales usos que hago de esta aplicación, nos permte crear rúbricas de forma sencilla, así como incluir recursos realizados con otras aplicaciones. Por ejemplo, Jclic, Descartes, Scratch, Geogebra, Physlets…

Más información: eXeLearning

La entrada Nueva versión de eXeLearning, tu editor de recursos educativos e interactivos se publicó primero en KDE Blog.

Member

Member baltolkien

baltolkien