Inferência com múltiplos vídeos

Inference v0.9.18 é uma plataforma de código aberto projetada para simplificar o processamento modelos de visão computacional. Ela permite que desenvolvedores realizem detecção de objetos, classificação e segmentação de instâncias, além de utilizar modelos de base como CLIP, Segmentação e YOLO-World através de um pacote nativo Python, este software é um servidor de inferência auto-hospedado ou uma API totalmente gerenciada.

Com isto é possível executar múltiplas transmissões de vídeo através de um único pipeline, aplicações para monitorar a eficiência de lojas de varejo, detecção de objetos pequenos e muito mais.

Com esta versão tornou possível processar múltiplos vídeos e transmissões usando um pipeline. Com múltiplas transmissões em um pipeline, você pode simplificar sua arquitetura de serviço de modelo e trazer transmissões de várias câmeras de borda para um único pipeline para processamento em uma única GPU. Essa configuração é ideal para ambientes de fabricação que operam múltiplas linhas em um único local para garantir que a produtividade permaneça alta enquanto reduz o hardware necessário para executar o processamento na borda.

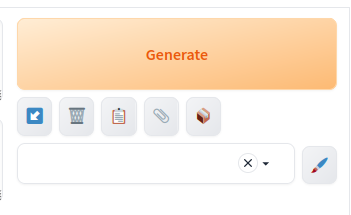

Como funciona o InferencePipeline?

InferencePipeline gira uma thread consumidor de fonte de vídeo para cada referência de vídeo fornecida. Quadros dos vídeos são capturados por um multiplexador de vídeo que espera por um timeout de coleta de lote (se a fonte não fornecer um quadro, um lote menor será passado para on_video_frame, mas quadros ausentes e previsões serão preenchidos com None antes de passar para on_prediction . O on_prediction pode trabalhar no modo SEQUENCIAL (apenas um elemento de cada vez), ou no modo LOTE – todos os elementos do lote ao mesmo tempo, e isso pode ser controlado pelo parâmetro sink_mode.

Para arquivos de vídeo estáticos, InferencePipeline processa todos os quadros por padrão, para transmissões – é possível descartar quadros dos buffers – em favor de sempre processar os dados mais recentes (quando a inferência do modelo é lenta, mais quadros podem ser acumulados no buffer – o processamento de transmissão descarta quadros mais antigos e só processa o mais recente).

Para aumentar a estabilidade, no caso de processamento de transmissões – as fontes de vídeo serão automaticamente reconectadas uma vez que a conectividade for perdida durante o processamento. Isso é destinado a prevenir falhas em ambiente produtivo quando o pipeline pode funcionar por longas horas e precisa lidar de forma graciosa com tempos de inatividade das fontes.

Mais informações no github: https://github.com/roboflow/inference

Grok-1 opensource: Um Marco na história da IA.

A comunidade de desenvolvimento de inteligência artificial (IA) recebeu recentemente uma notícia empolgante: Grok-1, um modelo com 314 bilhões de parâmetros, agora é totalmente de código aberto, cortesia da xAI. Esta é uma mudança significativa no cenário da IA, já que o Grok-1 é um grande modelo disponibilizado como código aberto até o momento

Antes dessa abertura, o Grok-1 era um modelo não refinado, cuja fase de pré-treinamento foi concluída em outubro de 2023. Isso significa que ele ainda não foi otimizado para aplicações específicas e pode não ser tão orientado para a segurança quanto modelos comparáveis. No entanto, seu tamanho e potencial são impressionantes.

O que torna o Grok-1 tão importante é sua disponibilidade como código aberto. Isso significa que os desenvolvedores agora têm acesso direto ao modelo, podendo explorá-lo, fazer melhorias e personalizá-lo para atender às suas necessidades específicas. Em contraste, modelos como GPT-4 da OpenAI são de código fechado, o que limita severamente a capacidade dos programadores de entenderem ou ajustarem o modelo.

Uma analogia útil é pensar no Grok-1 como uma foto digital, enquanto modelos de código fechado são como fotos físicas. Com acesso ao código e aos pesos do Grok-1, os desenvolvedores podem “editar” o modelo, ajustando-o para comportar-se de maneira diferente ou treinando-o para tarefas específicas, como análise de documentos médicos em sueco.

Essa capacidade de personalização é crucial para atender às demandas variadas da IA em diferentes setores e contextos. Por exemplo, um desenvolvedor que deseja criar um aplicativo para analisar artigos médicos em sueco agora pode treinar o Grok-1 especificamente para essa tarefa, tornando seu aplicativo muito mais eficaz do que se dependesse de modelos de código fechado.

Além disso, a abertura do Grok-1 como código aberto promete acelerar a inovação e o desenvolvimento na indústria de IA como um todo. Ao permitir que desenvolvedores em todo o mundo compartilhem conhecimentos e façam melhorias colaborativas, podemos esperar avanços mais rápidos e significativos no campo da IA.

Portanto, o Grok-1 não é apenas mais um modelo de IA disponível – é um marco na democratização e na disponibilidade de modelos de IA de ponta. À medida que exploramos as oportunidades que ele oferece, é crucial que também consideremos as implicações éticas e de segurança associadas ao seu uso. Com a comunidade de desenvolvimento trabalhando em conjunto, podemos garantir que a IA continue a avançar de maneira responsável e benéfica para a sociedade.

Código Fonte no github: https://github.com/xai-org/grok-1

Corrigindo mãos em imagens criadas com IA.

A Stable Diffusion e outras tecnologia de modelos probabilísticos de difusão enfrenta um problema com mãos. É bastante comum ver mãos deformadas ou com dedos faltando ou extras. Neste texto, vamos explorar algumas maneiras de corrigir mãos baseado no paper arXiv:2311.17957 .

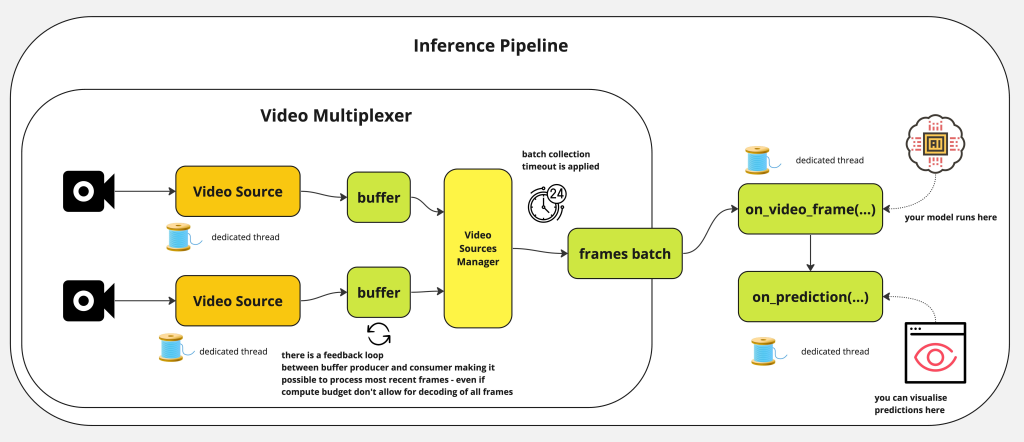

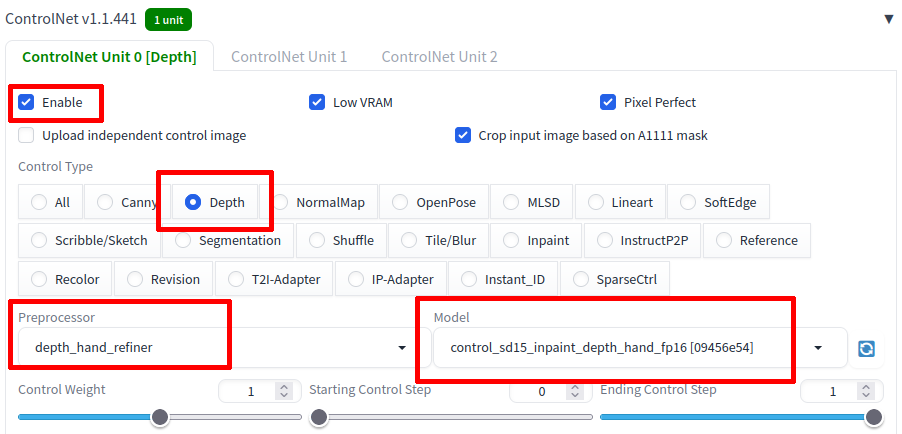

Baseado no estudo, o paper apresentou uma solução de pós-processamento leve chamada HandRefiner para corrigir mãos malformadas em imagens geradas. O HandRefiner utiliza uma abordagem de inpainting condicional para retificar mãos malformadas, deixando outras partes da imagem inalteradas. Foi utilizado o modelo de reconstrução de malha de mão que adere consistentemente ao número correto de dedos e à forma da mão, sendo também capaz de ajustar a pose desejada da mão na imagem gerada. Dada uma imagem gerada falha devido a mãos malformadas, utiliza-se o módulos ControlNet para reinjetar essas informações corretas de mão. Além disso, foi descoberto um fenômeno de transição de fase dentro do ControlNet à medida que variamos a força de controle. Isso nos permite tirar vantagem de dados sintéticos mais facilmente disponíveis sem sofrer com a lacuna de domínio entre mãos realistas e sintéticas.

O fontes do projetos estão no repositório github no link: https://github.com/wenquanlu/HandRefiner/

Para iniciarmos, devemos entrar no modo inpaint e transferir a imagem recém criada ou fazer o upload da imagem.

Agora no modo inpaint, selecione as mão, conforme o exemplo abaixo.

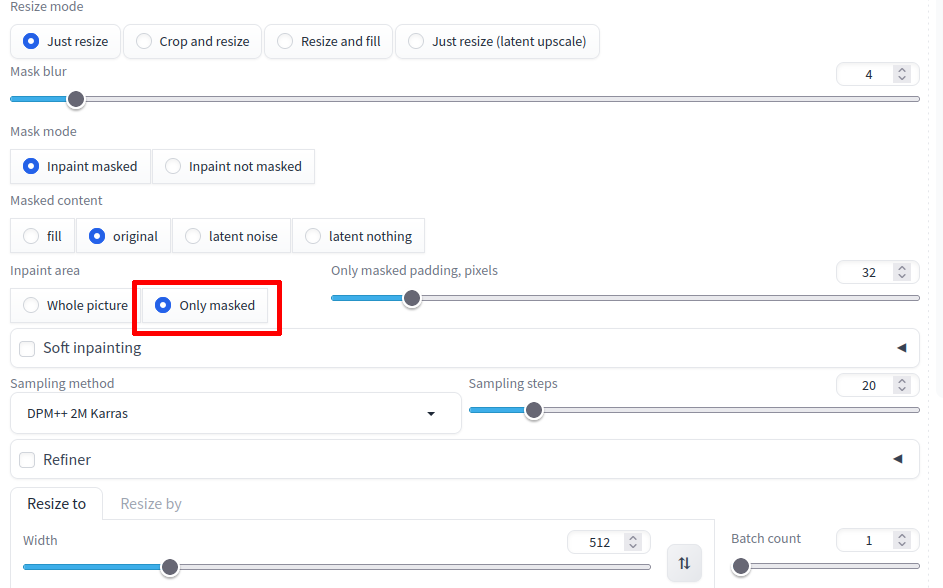

Agora em InPaint area, selecione a opção Only masked, conforme a ilustração abaixo.

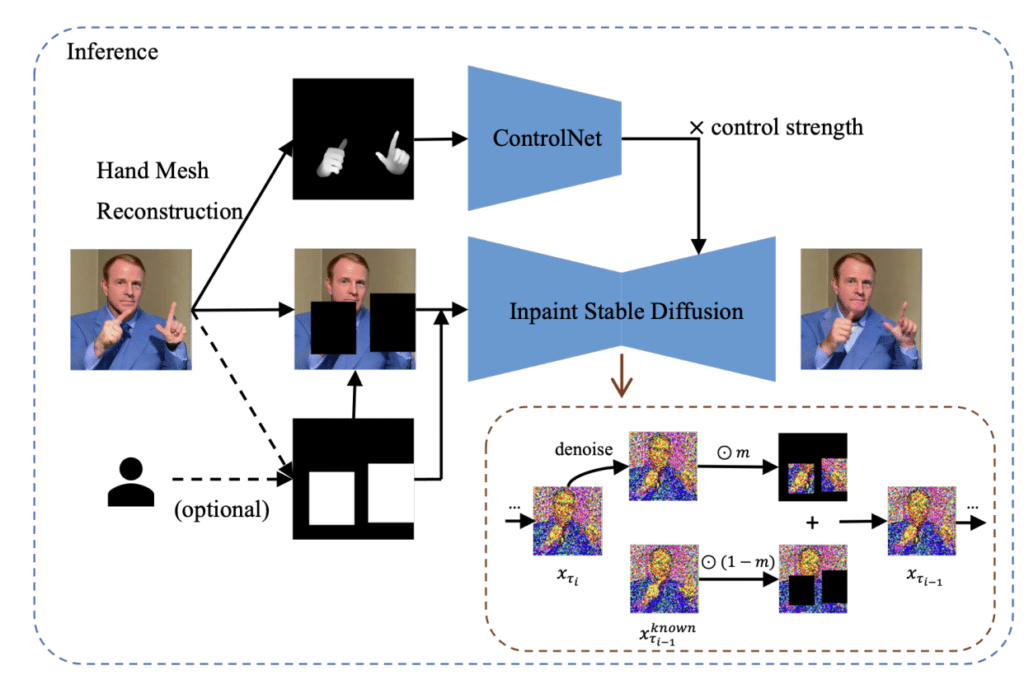

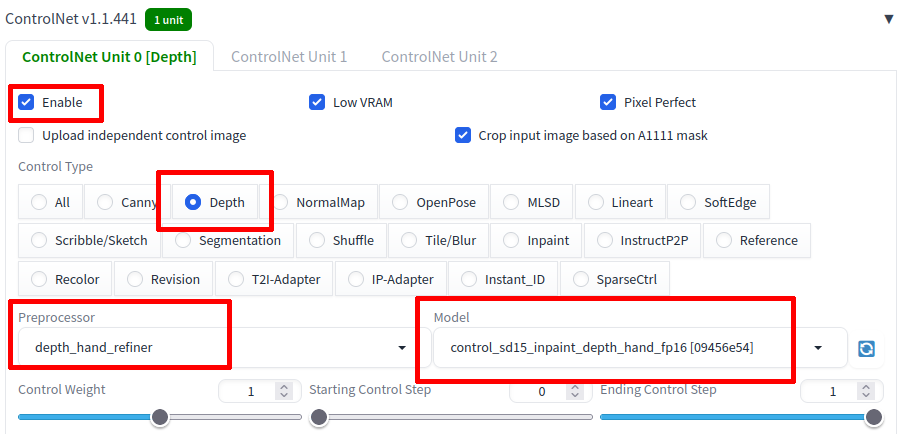

Como na figura abaixo, habilite a opção ControlNet, selecione o Contro Type Depth, na lista Proprocessor, selecione depth_hand_refiner e por fim o modelo control_sd15_inpaint_depth_hand_fp16.

Agora clique no botão Generate e pronto!

Se tudo estiver funcionando corretamente, teremos o resultado a seguir.

Foi apresentado com esta técnica, um método de inpainting condicional inovador baseado no ControlNet para corrigir mãos humanas malformadas em imagens geradas. Ao descobrir um fenômeno de transição de fase interessante ao variar a força de controle, foi permitido o treinamento de modelos em dados sintéticos facilmente disponíveis, mantendo ainda assim resultados de geração realistas. É proposto duas técnicas simples para determinar a força de controle na inferência e verificou-se quantitativa e qualitativamente sua eficácia. Por último, é demonstrado que a transição de fase é generalizável para outros sinais de controle e configurações.

Mais informações, aqui: https://github.com/wenquanlu/HandRefiner

Corrigindo mãos de imagens criadas com IA.

A Stable Diffusion e outras tecnologia de modelos probabilísticos de difusão enfrenta um problema com mãos. É bastante comum ver mãos deformadas ou com dedos faltando ou extras. Neste texto, vamos explorar algumas maneiras de corrigir mãos baseado no paper arXiv:2311.17957 .

Baseado no estudo, o paper apresentou uma solução de pós-processamento leve chamada HandRefiner para corrigir mãos malformadas em imagens geradas. O HandRefiner utiliza uma abordagem de inpainting condicional para retificar mãos malformadas, deixando outras partes da imagem inalteradas. Foi utilizado o modelo de reconstrução de malha de mão que adere consistentemente ao número correto de dedos e à forma da mão, sendo também capaz de ajustar a pose desejada da mão na imagem gerada. Dada uma imagem gerada falha devido a mãos malformadas, utiliza-se o módulos ControlNet para reinjetar essas informações corretas de mão. Além disso, foi descoberto um fenômeno de transição de fase dentro do ControlNet à medida que variamos a força de controle. Isso nos permite tirar vantagem de dados sintéticos mais facilmente disponíveis sem sofrer com a lacuna de domínio entre mãos realistas e sintéticas.

O fontes do projetos estão no repositório github no link: https://github.com/wenquanlu/HandRefiner/

Para iniciarmos, devemos entrar no modo inpaint e transferir a imagem recém criada ou fazer o upload da imagem.

Agora no modo inpaint, selecione as mão, conforme o exemplo abaixo.

Agora em InPaint area, selecione a opção Only masked, conforme a ilustração abaixo.

Como na figura abaixo, habilite a opção ControlNet, selecione o Contro Type Depth, na lista Proprocessor, selecione depth_hand_refiner e por fim o modelo control_sd15_inpaint_depth_hand_fp16.

Agora clique no botão Generate e pronto!

Se tudo estiver funcionando corretamente, teremos o resultado a seguir.

OpenVINO 2024.0.0 lançado!

A semana passada foi lançado a versão 2024.0.0 do openVINO, abaixo os principais destaques:

Mais cobertura de IA Genérica e integrações de frameworks para minimizar alterações no código:

A versão 2024.0 do OpenVINO, lançada pela Intel, introduz avanços significativos em IA generativa (GenAI) e uma nova API JavaScript, reforçando seu compromisso com a otimização e implementação de inferências de IA em uma gama diversificada de plataformas de hardware. Este kit de ferramentas de código aberto se destaca por sua capacidade de acelerar a inferência de IA não somente em CPUs x86_64, mas também em CPUs ARM, diversas arquiteturas, GPUs Intel integradas e dedicadas, além de aproveitar a nova Unidade de Processamento Neural (NPU) Intel através do plugin NPU, especialmente projetado para os SoCs Core Ultra “Meteor Lake” recentemente lançados.

Com esta atualização, o OpenVINO 2024.0 concentra-se ainda mais em capacidades de IA generativa, aprimorando a experiência do usuário com modelos de codificação de sentenças TensorFlow, introduzindo suporte para Mix of Experts (MoE), disponibilizando uma API JavaScript para acesso simplificado à API OpenVINO, e garantindo modelos validados para Mistral, entre outras novidades.

Suporte mais amplo para modelos LLM e mais técnicas de compressão de modelos:

Além disso, essa nova versão melhora significativamente a compressão de pesos INT4 para Modelos de Linguagem de Grande Escala (LLMs), eleva o desempenho dos LLMs em CPUs Intel, e facilita a otimização e conversão de modelos Hugging Face, além de incluir outras melhorias relevantes à integração com Hugging Face.

O OpenVINO 2024.0 também marca o fim do suporte ao anterior Gaussian e Neural Accelerator (Intel GNA), voltando agora sua atenção para a NPU disponível nos SoCs Meteor Lake e versões mais recentes. Notavelmente, o plugin Intel NPU é agora incorporado ao pacote principal do OpenVINO disponível no PyPi, beneficiando não apenas os usuários de tecnologia Intel, mas também oferecendo melhor desempenho em CPUs ARM e várias otimizações de plataforma para usuários de diferentes ecossistemas.

Mais informações no repositorio oficial: https://github.com/openvinotoolkit/openvino/releases/tag/2024.0.0

Novos códigos All Star Tower Defense

As seguir a lista dos últimos códigos do jogo All Tower Defense que podem ser trocados por joias gratuitas, que você usa para invocar novos personagens para ajudar na defesa contra seus inimigos.

- blamspot500kcodeunitrelease – (novo)

- videocode12135 – 100 joias e 2.400 Gemas (novo)

- EnumaElish2024 – 400 joias e 7.300 Gema (nível 60 ou superior) (novo)

Provador de roupa Virtual com IA.

A difusão latente de IA representa uma inovação revolucionária no setor da moda, especialmente na forma como consumidores experimentam e selecionam roupas. Utilizando técnicas avançadas de inteligência artificial, essa tecnologia permite que os usuários provem roupas virtualmente com uma precisão e realismo impressionantes. Ao invés de se basear em simples sobreposições de imagens, a difusão latente analisa as características físicas do usuário, como a forma do corpo, a postura e as dimensões, para ajustar digitalmente as roupas de maneira que reflitam como elas ficariam no mundo real. Isso não só melhora a experiência de compra online, oferecendo uma visualização mais fidedigna do produto, mas também minimiza as taxas de retorno devido a expectativas não atendidas.

Além de beneficiar os consumidores, a difusão latente de IA é uma ferramenta valiosa para os varejistas e designers de moda. Ela permite uma análise detalhada das preferências e tendências de moda, ajustando os estoques e as coleções para atender melhor às demandas dos consumidores. Com a capacidade de simular uma ampla variedade de tecidos, estilos e cortes em diferentes corpos virtuais, os designers podem experimentar e iterar designs rapidamente sem a necessidade de produzir amostras físicas. Essa abordagem não apenas economiza tempo e recursos, mas também abre caminho para uma moda mais sustentável e personalizada, transformando a maneira como interagimos com as roupas em um ambiente digital.

YOLO v9 Chegou!

O YOLOv9 surgiu dia 21 de fevereiro de 2024 pelos pesquisadores Chien-Yao Wang, I-Hau Yeh e Hong-Yuan Mark Liao, no artigo “YOLOv9: Learning What You Want to Learn Using Programmable Gradient Information”, este modelo demonstrou uma precisão superior em comparação aos modelos YOLO antecessores.

O YOLOv9 representa um avanço significativo na detecção de objetos, superando o desempenho do YOLOv8 com inovações como o Programmable Gradient Information (PGI) e a arquitetura Generalized Efficient Layer Aggregation Network (GELAN). O PGI permite a preservação completa da informação de entrada, essencial para a atualização eficaz dos pesos da rede, enquanto a GELAN melhora a eficiência dos parâmetros. Testado no dataset MS COCO, o YOLOv9 mostrou-se mais eficiente e preciso que seus predecessores, utilizando menos parâmetros e cálculos. O código-fonte e as instruções foram disponibilizados pelos autores, embora algumas versões dos pesos e licenças estejam pendentes.

Fonte:

Melo Júnior, José Carlos de. “YOLOv9: Aprenda a Detectar Objetos”. Blog do Sigmoidal, 24 fev. 2024. Disponível em: https://sigmoidal.ai/yolov9-aprenda-a-detectar-objetos

Stable Diffusion 3

Anunciando o Stable Diffusion 3 em prévia antecipada, um modelo de texto para imagem mais capaz, com desempenho muito melhorado em prompts de múltiplos sujeitos, qualidade de imagem e habilidades de ortografia.

Embora o modelo ainda não esteja amplamente disponível, hoje, estamos abrindo a lista de espera para uma prévia antecipada. Esta fase de prévia, como com os modelos anteriores, é crucial para coletar insights para melhorar seu desempenho e segurança antes de um lançamento aberto. Você pode se inscrever para entrar na lista de espera aqui.

O conjunto de modelos do Stable Diffusion 3 atualmente varia de 800M a 8B parâmetros. Esta abordagem visa alinhar-se com nossos valores centrais e democratizar o acesso, fornecendo aos usuários uma variedade de opções para escalabilidade e qualidade para atender melhor às suas necessidades criativas. O Stable Diffusion 3 combina uma arquitetura de transformador de difusão e correspondência de fluxo. Publicaremos um relatório técnico detalhado em breve.

Acreditamos em práticas de IA seguras e responsáveis. Isso significa que estão tomando medidas razoáveis para prevenir o mau uso do Stable Diffusion 3 por atores mal-intencionados. A segurança começa quando inicia-se o treinamento do nosso modelo e continua ao longo do teste, avaliação e implantação. Em preparação para esta prévia antecipada, introduzimos inúmeras salvaguardas. Ao colaborar continuamente com pesquisadores, especialistas e nossa comunidade, esperamos inovar ainda mais com integridade à medida que nos aproximamos do lançamento público do modelo.

O compromisso em garantir que a IA gerativa seja aberta, segura e universalmente acessível permanece firme. Com o Stable Diffusion 3, teve muito esforço para oferecer soluções adaptáveis que permitam a indivíduos, desenvolvedores e empresas liberar sua criatividade, alinhando-se com nossa missão de ativar o potencial da humanidade.

Se você gostaria de explorar o uso de um de outros modelos de imagem para uso comercial antes do lançamento do Stable Diffusion 3, visite a página de Membership da Stability AI para auto hospedagem ou nossa Plataforma de Desenvolvedor para acessar nossa API.

Para ficar atualizado sobre o progresso, siga as novidades no Twitter, Instagram, LinkedIn e junte-se à Comunidade Discord.

NVIDIA lança chatbot local

A NVIDIA introduziu seu mais recente chatbot, equipado com capacidades de IA local, destinado aos detentores de suas placas de vídeo GeForce RTX séries 30 e 40. A inovação, denominada “Chat with RTX”, é um chatbot para computadores com sistema operacional Windows, desenvolvido com o apoio da tecnologia TensorRT-LLM, e já se encontra disponível sem custos para os modelos mais recentes das GPUs RTX. Esta solução apresenta uma mecânica de operação simples, no entanto, proporciona uma gama de possibilidades bastante ampla para os usuários, oferecendo a vantagem de empregar funcionalidades de chatbot de IA diretamente no local, eliminando a necessidade de conexão com a internet.

Projetado para funcionar como um sistema local e personalizável, o “Chat with RTX” assegura disponibilidade contínua no computador do usuário sem exigir acesso à internet. A personalização da experiência do usuário é viável através do uso de um conjunto de dados armazenado localmente no PC, sendo compatível com a maioria das GPUs das séries RTX 40 e RTX 30.

O “Chat with RTX”, viabilizado pelo software TensorRT-LLM & Retrieval Augmented Generation (RAG) da NVIDIA, foi lançado para PCs Windows no ano anterior, garantindo compatibilidade com todas as placas GeForce RTX séries 30 e 40 que possuem no mínimo 8GB de VRAM. Para os proprietários de placas compatíveis da NVIDIA, é possível realizar o download gratuito do “Chat with RTX” através do site oficial da empresa. Os usuários têm a possibilidade de vincular o chatbot a um acervo de dados local no PC, abrangendo formatos como .txt, .pdf, .doc, .docx, .xml, utilizando modelos de linguagem avançados, como Mistral e Llama 2, sendo necessário para isso os sistemas operacionais Windows 11 ou Windows 10 e os drivers mais recentes de GPU da NVIDIA para um desempenho otimizado.

cabelo

cabelo