Anunciada la conf.kde.in 2024

Lo cierto es que poder realizar esta entrada me parece fabuloso. Y es que la frase «Piensa en global, actúa en global» es ideal para entender como debe funcionar un movimiento comunitario. Tengamos un proyecto para todo el mundo pero trabajemos coordinados con los que estamos cerca. Ha sido anunciada la conf.kde.in 2024, es decir, la versión india de la Akademy Internacional o, lo que es más acertado, la versión india de Akademy-es ya que se acerca más a esa idea.

Anunciada la conf.kde.in 2024

Por alguna razón la conf.kde.in nunca ha aparecido en el blog. Quizás su anuncio me pillara un poco saturado de trabajo o que se ha hecho poca promoción, pero lo cierto es que es hora de enmendar este error.

Para poner un poco de contexto la conf.kde.in es un evento donde los simpatizantes y desarrolladores de la India se reunen para realiar charlas, talleres y, sobre todo, compartir tiempo juntos y estrechar lazos.

La conf.kde.in se inició en 2011 en el R V College of Engineering de Bangalore por un grupo de colaboradores indios de KD, desde entonces hemos celebrado seis ediciones diferentes, cada una en universidades y lugares distintos: Gandhinagar (dos años seguidos), Amrita University (Kerala), LNMIIT (Jaipur), IIT Guwahati y, la última en Maharaja Agrasen Institute of Technology (Delhi).

Estos eventos lograron atraer a estudiantes indios a programas de tutoría como Google Summer of Code (GSoC), Season of KDE y Google Code-In. Estos programas a menudo han ayudado con éxito a los estudiantes a convertirse en colaboradores de por vida de las comunidades de código abierto, incluida KDE.

Es por ello que me complace en anunciar que conf.kde.in 2024 se celebrará en la Universidad Tecnológica COEP de Pune del 2 al 4 de febrero, con el objetivo de atraer a nuevos miembros de la Comunidad KDE, así como a desarrolladores experimentados. Los contenidos de la conferencia proporcionan información actualizada sobre lo que está ocurriendo en la Comunidad KDE y enseña a los recién llegados cómo empezar a hacer contribuciones significativas.

En la edición de este año, el evento atraerá de nuevo a ponentes de toda la India, proporcionando a los estudiantes una excelente oportunidad para interactuar con colaboradores de código abierto establecidos, así como con desarrolladores de diversas industrias que trabajan en proyectos de código abierto en los campos de la automoción, los sistemas integrados, los móviles, etc.

Como es casi obvio, yo no podré asisitir pero estaré atento para proporcionar todo tipo de información de este evento.

Más información: conf.kde.in 2024

La entrada Anunciada la conf.kde.in 2024 se publicó primero en KDE Blog.

Cómo crear sopas de letras con eXeLearning – Vídeo

Hace ya casi dos años que presenté eXeLearning, un editor de recursos educativos e interactivos de código abierto que te permite llevar tu actividades a otro nivel a la vez que compartirlos sin ningún tipo de restricción en multitud de formatos. Lo cierto es que me interesa mucho esta aplicación y he empezado a aprender mucho sobre ella, y es mi deber pagarlo mediante promoción. Hoy os traigo cómo crear Sopa de letras con eXeLearning , un vídeo de Cedec_Intef que explica muy bien los principios básicos en 6 pasos.

Cómo crear sopas de letras con eXeLearning – Vídeo

Seguimos con eXeLearning, y en esta ocasión con un vídeo de Cedec_Intef, que no es más que el Centro Nacional de Desarrollo Curricular en Sistemas no Propietarios (Cedec), un organismo público español que promueve la transformación digital y metodológica de las aulas que pone a disposición de los docentes recursos educativos abiertos (REA) del Proyecto EDIA, elaborados por docentes en activo con la herramienta de software libre eXeLearning.

Pues bien, en el vídeo que os presento hoy se explica en varios pasos cómo crear sopas de letras con Exelarning, bien sea poniendo pistas en forma de definición, imágen o sonido. Algo mucho más sencillo de lo que parece.

¿Qué es EXeLearning?

Para los que no lo conozcan, eXeLearning es un editor de recursos educativos e interactivos de código abierto se caracteriza por:

- Permite crear contenidos educativos de una manera sencilla

- Descarga fácil y gratuita desde su web.

- Está disponible para todos los sistemas operativos.

- Nos pemite catalogar los contenidos y publicarlos en diferentes formatos:

- Sitio web navegable y adaptable a diferentes dispositivos (responsive design).

- Estándar educativo, para trabajar con Moodle y otros LMS.

- Página HTML única para imprimir cómodamente tu trabajo.

- ePub3 (libro electrónico), etc.

- Ofrece diferentes diseños a elegir desde el menú, además de la posibilidad de crear diseños propios.

Con eXelearnig se puede crear todo tipo de actividades entre las que destaco rellenar huecos, pregunta de elección múltiple, pregunta de selección múltiple, pregunta verdadero-falso, cuestionario SCORM o actividad desplegable.

Además, y este es uno de los principales usos que hago de esta aplicación, nos permte crear rúbricas de forma sencilla, así como incluir recursos realizados con otras aplicaciones. Por ejemplo, Jclic, Descartes, Scratch, Geogebra, Physlets…

La entrada Cómo crear sopas de letras con eXeLearning – Vídeo se publicó primero en KDE Blog.

Cómo crear sopas de letras con eXeLearning – Víde

Hace ya casi dos años que presenté eXeLearning, un editor de recursos educativos e interactivos de código abierto que te permite llevar tu actividades a otro nivel a la vez que compartirlos sin ningún tipo de restricción en multitud de formatos. Lo cierto es que me interesa mucho esta aplicación y he empezado a aprender mucho sobre ella, y es mi deber pagarlo mediante promoción. Hoy os traigo cómo crear Sopa de letras con eXeLearning , un vídeo de Cedec_Intef que explica muy bien los principios básicos en 6 pasos.

Cómo crear sopas de letras con eXeLearning – Vídeo

Seguimos con eXeLearning, y en esta ocasión con un vídeo de Cedec_Intef, que no es más que el Centro Nacional de Desarrollo Curricular en Sistemas no Propietarios (Cedec), un organismo público español que promueve la transformación digital y metodológica de las aulas que pone a disposición de los docentes recursos educativos abiertos (REA) del Proyecto EDIA, elaborados por docentes en activo con la herramienta de software libre eXeLearning.

Pues bien, en el vídeo que os presento hoy se explica en varios pasos cómo crear sopas de letras con Exelarning, bien sea poniendo pistas en forma de definición, imágen o sonido. Algo mucho más sencillo de lo que parece.

¿Qué es EXeLearning?

Para los que no lo conozcan, eXeLearning es un editor de recursos educativos e interactivos de código abierto se caracteriza por:

- Permite crear contenidos educativos de una manera sencilla

- Descarga fácil y gratuita desde su web.

- Está disponible para todos los sistemas operativos.

- Nos pemite catalogar los contenidos y publicarlos en diferentes formatos:

- Sitio web navegable y adaptable a diferentes dispositivos (responsive design).

- Estándar educativo, para trabajar con Moodle y otros LMS.

- Página HTML única para imprimir cómodamente tu trabajo.

- ePub3 (libro electrónico), etc.

- Ofrece diferentes diseños a elegir desde el menú, además de la posibilidad de crear diseños propios.

Con eXelearnig se puede crear todo tipo de actividades entre las que destaco rellenar huecos, pregunta de elección múltiple, pregunta de selección múltiple, pregunta verdadero-falso, cuestionario SCORM o actividad desplegable.

Además, y este es uno de los principales usos que hago de esta aplicación, nos permte crear rúbricas de forma sencilla, así como incluir recursos realizados con otras aplicaciones. Por ejemplo, Jclic, Descartes, Scratch, Geogebra, Physlets…

La entrada Cómo crear sopas de letras con eXeLearning – Víde se publicó primero en KDE Blog.

Music of the week: Christmas edition :-)

If it’s Christmas, then for many people it means watching Home alone. Related memes have appeared in social media already in the summer: “100 more days before you watch Home Alone again” ;-) Well, I do not recall when I watched it for the last time, so probably not in the past decade…

However, even I know that the most famous song from the movie is Carol of the Bells. I was surprised to hear how many musicians make a cover of a song from a film. Well, if you check out the Wikipedia article above, you will see that this is not a song by John Williams. Long story short: the song originates from Ukraine, and the English version is less than a century old. Let’s start listening to the most famous version:

TIDAL: https://listen.tidal.com/album/52597873/track/52597885

There are many cover versions of this song. Even the Wikipedia article has a long list, but if you search for “Carol of the Bells” on YouTube or TIDAL, you will find many more. Probably the most famous, apart from “Home Alone”, is made by The Piano Guys:

TIDAL: https://listen.tidal.com/album/23004975/track/23004979

Of course, there are also countless metal versions. I listened to a few, and I liked the version by Charlie Parra del Riego the most:

TIDAL: https://listen.tidal.com/album/221145965/track/221145967

You know a song is an integral part of popular culture when it appears in a game soundtrack:

TIDAL: https://listen.tidal.com/album/333849250/track/333849251

And for now, something completely different. One of the most famous Hungarian folk music groups is Kaláka. Every year they hold a Christmas concert, where they sing many Christmas songs, Hungarian folk traditions and others, as well. A couple of times I was lucky enough to participate in these concerts. The following video shows how they walk in to the stage singing:

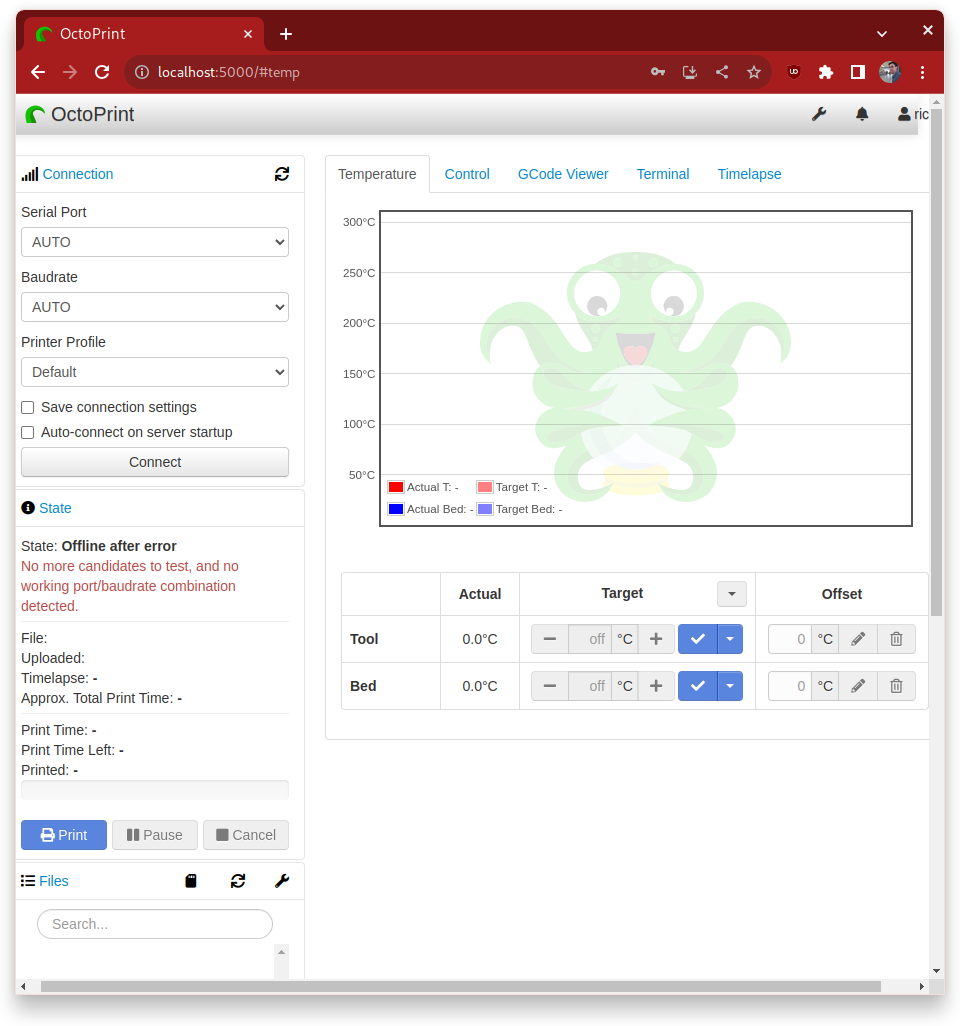

My Mini Delta Also Doesn't work with Cura :(

My Mini Delta Also Doesn't work with Cura :(

I need to why it works with OctoPi but why OctoPrint and Cura can't detect my printer on plain old OpenSuse. Some missing plugin or something?

alpでgrafana workloadを動かしてみる

さて、毎度ながらの説明ですが、ALP (Adaptive Linux Platform)は、SUSEとopenSUSEで開発している次世代OSのベースです。イミュータブルで軽量な仕様となっています。

この冬発売のGeeko MagazineにインストールとCockpitというブラウザから管理できるアプリの体験記を書いていますので、ぜひ皆さん試してみてください。

ここ何回かalpについて記事を書いていて、やっとわかってきました。SUSE/openSUSEは、ホストとの連携が必要などの単に動かすだけでない処理が必要なアプリのインストールや準備処理を、コンテナに内包して、workloadとして動かす、という戦略をとってるものがります。その時に利用するのが、podmanのlabel付け(実行コマンドにlabelをつける)と、そのlabel名で呼び出すrunlabelオプションです。

今回はgrafanaをマニュアルに従って動かしてみます。

grafanaサーバーのセットアップ

まず、workload内包コンテナを探します。

# podman search grafanaあれ?一覧にworkloadのコンテナが出てきません。直接レジストリ名を指定してみます。

# podman search registry.opensuse.org/suse/alp/workloads/tumbleweed_containerfiles/suse/alp/workloads/grafana表示されました。

では、イメージをpullしてワークロードを実行します。

# podman container runlabel install

registry.opensuse.org/suse/alp/workloads/tumbleweed_containerfiles/suse/alp/workloads/grafana:latest容量があり1分ほど時間がかかりましたが、準備が完了しました。

grafanaのworkloadは、grafana-container-manage.shというスクリプトを用意してくれ、これを使ってコンテナの作成や実行などを行います。

まずは、コンテナを作成します。

# grafana-container-manage.sh createすぐにコンテナが作成されました。

では、コンテナをgrafanaのサーバーと共に実行します。

# grafana-container-manage.sh start今は指示通りコマンドを叩いてるだけですが、それぞれが何をしているかを見てみるのも楽しそうですね。

grafanaクライアントのセットアップ

今回はalpを動かしているホストをクライアントにしようと思います。

クライアントには、以下の2つのパッケージをインストールし、サービスを再起動します。

パッケージのインストール

- golang-github-prometheus-node_exporter

- golang-github-prometheus-prometheus

サービスの再起動

- systemctl restart prometheus-node_exporter.service

- systemctl restart prometheus

grafanaでの表示

では、grafanaを設定していきます。

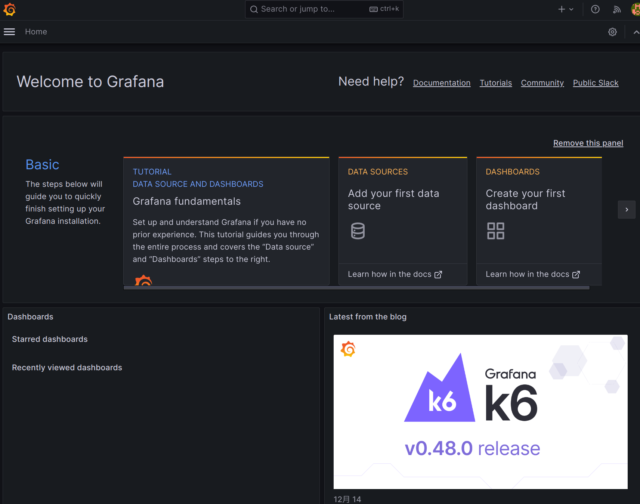

ブラウザからgrafanaにアクセスします。

http://[ALP_HOST_IP]:3000

ログイン画面が表示されるので、ログインします。初期設定は両方ともadminとなっています。ログイン後、パスワード変更画面になりますので新しいパスワードを設定します。

ログインしたら、ホストのprometheusからデータを取得します。

上段の真ん中にある「DATA SOURCES」をクリックし、種類の一覧が表示されるので一番上の「Prometheus」を選択します。

Prometheus server URLに、Prometheusを動かしているマシンのurlを指定します。デフォルトでポートは9090です。僕の場合、alpを動かしているホストなのでhttp://192.168.122.1:9090となりました。

ホストのlibvirtのゾーンで9090を開放し、画面下部の「Save & test」ボタンをおすと、Successfullyと出てきました。

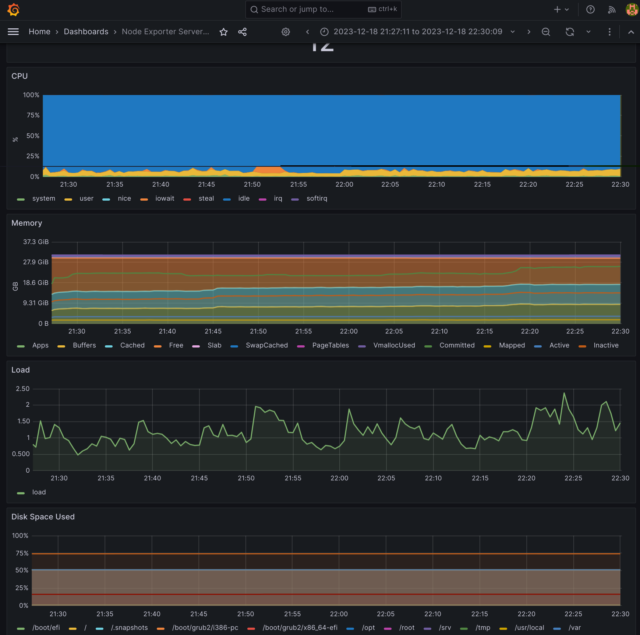

サンプルで用意されているDashboardsを読み込んでみます。マニュアルはバージョンが古いようで、僕が試した時は以下の手順になりました。

- 左上のハンバーガーメニューから、Dashboardsを選択する

- 右側にある「New」のボタンをクリックして出てくるドロップダウンから、Importを選択する

- Import via grafana.comに、405と入力して「Load」をクリックする

- prometheusをクリックして、データソースを選択する 手順通りだと一つのため、それを選択する

- 設定が読み込まれるので、下の「Import」をクリックする

無事、グラフが表示されました。

grafanaを制御するスクリプトには他にもアンインストールやキャッシュ削除などのオプションがありますので、追って紹介しようと思います。

A New Print

A New Print

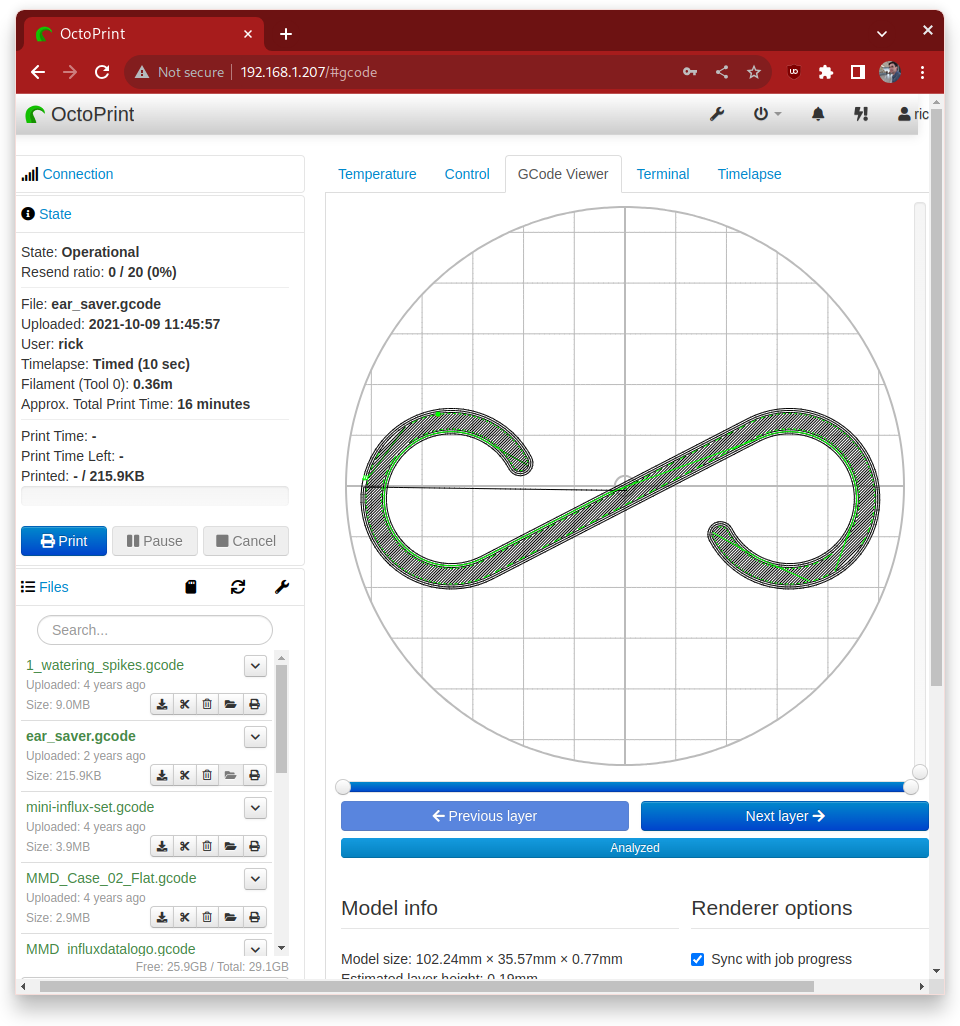

This morning I wanted to see if I could print something new. This entails getting Cura set up on my OpenSuse machine. I was worried it would be difficult, but it was anything but. I was easily able to find the download Cura page, and to download the AppImage version.

I wasn't quite sure how to actually use it, but it turned out I could just chmod and run it.

Cura started up quickly, and walked me through creating an account (not sure if that is needed) and configuring my printing.

After I followed the wizard, I could see that my printer was nicely configured.

Then I did a little searching to find something that I wanted, but was also quick and easy to print. I found this.

I downloaded the STL file and loaded into Cura, and then clicked slice. I forgot to change some defaults which I only slightly regret, you'll see why in a minute.

After saving the generated gcode, I opened an old gcode file that I had and replaced the first part of the new file with these old commands. I learned from trial and error the best set of start up commands years ago, so I always reuse them. I stuck the commands here in case you have the same printing and are interested.

Then I just needed to load the new gcode file into Octoprint. I forgot to configure Cura to tell it not to create that base, as I think it isn't necessary for this kind of print, but, no harm done, really.

And now it's printing. The print is going fine. Would probably be cleaner if I didn't keep shaking the work bench as a type this :) Just as the print was finishing up, I realized that the filament I was using is simply transparent, not glow in the dark. It made the key ring sort of weird looking. I swear I had a spool of glow in the dark filament, but, if so, I have no idea what I did with it.

Guide Pas à Pas pour Supprimer My AI : Un Tutoriel Simplifié

Pour supprimer My AI de votre iPhone d’Apple, il existe quelques méthodes simples à suivre. Avant tout, il est important de comprendre comment My AI fonctionne et pourquoi vous pourriez vouloir le supprimer de votre appareil. My AI est une fonctionnalité intégrée à l’iPhone qui utilise des données de localisation et des informations personnelles pour fournir des suggestions personnalisées. Certains utilisateurs peuvent préférer ne pas utiliser cette fonctionnalité pour des raisons de confidentialité ou préférer utiliser une autre application similaire. Dans cet article, nous vous présenterons les étapes pour supprimer My AI, avec ou sans l’utilisation de Snapchat+.

Comment faire pour supprimer My AI sur l’iPhone d’Apple ?

Pour supprimer My AI de votre iPhone, vous devrez passer par certaines étapes spécifiques. Voici comment vous pouvez procéder : 1. Ouvrez les paramètres de votre iPhone et accédez à la section « Confidentialité ». 2. Ensuite, sélectionnez « Services de localisation » et désactivez l’option « My AI ». 3. Vous devrez peut-être autoriser l’accès à votre localisation pour certaines applications après avoir désactivé My AI. Ces étapes simples vous permettront de supprimer My AI de votre iPhone et de désactiver ses fonctionnalités.

L’utilisation de Snapchat+ est indispensable pour enlever My AI

Pour supprimer My AI de manière plus complète et efficace, l’utilisation de l’application Snapchat+ est recommandée. Snapchat+ est une application de gestion de la confidentialité qui permet de supprimer les données de localisation et d’autres informations personnelles des applications et des services en ligne. En utilisant Snapchat+, vous pouvez empêcher My AI d’accéder à certaines informations personnelles, ce qui contribue à protéger votre vie privée.

Comment supprimer My AI sans avoir Snapchat+ ?

Si vous ne souhaitez pas utiliser Snapchat+ mais que vous souhaitez toujours supprimer My AI, il existe d’autres options. Vous pouvez explorer les paramètres de confidentialité de votre iPhone pour restreindre l’accès aux données de localisation et d’autres informations personnelles pour l’application My AI. Bien que cette méthode ne soit pas aussi complète que l’utilisation de Snapchat+, elle peut tout de même vous aider à limiter le fonctionnement de My AI sur votre iPhone.

Comment utiliser My AI ?

Si vous prévoyez d’utiliser My AI sur votre iPhone, vous pouvez l’activer en accédant aux paramètres de localisation et en autorisant l’application à accéder à vos informations personnelles. Une fois activé, My AI utilisera ces informations pour vous fournir des suggestions personnalisées en fonction de votre emplacement, de vos habitudes et de vos préférences.

Comment supprimer My AI ?

Pour récapituler, voici un tableau résumant les étapes pour supprimer My AI et les méthodes alternatives disponibles :

| Méthode | Avantages | Inconvénients |

|---|---|---|

| Paramètres de confidentialité de l’iPhone | Facile à effectuer | Moins complet que l’utilisation de Snapchat+ |

| Snapchat+ | Plus complet en termes de confidentialité | Nécessite l’installation d’une application tierce |

En suivant ces étapes, vous pourrez facilement contrôler l’accès de My AI à vos données personnelles et décider si vous souhaitez l’utiliser ou le supprimer de votre iPhone. Leçons apprises : Il est important de comprendre les implications de l’utilisation de My AI et de savoir comment le gérer sur votre iPhone. En utilisant les paramètres de confidentialité de l’iPhone ou des applications tierces telles que Snapchat+, vous pouvez protéger efficacement vos informations personnelles et personnaliser votre expérience utilisateur selon vos préférences.

FAQ

Comment supprimer My AI sans avoir Snapchat+ ?

Pour supprimer My AI, vous n’avez pas besoin de Snapchat+. Allez simplement dans les paramètres de l’application My AI et cherchez l’option pour supprimer ou désactiver votre compte. Suivez les instructions fournies.

Qui est MY Al sur SNAP ?

Je suis désolé, mais il n’y a pas d’informations disponibles sur une personne ou un compte nommé ‘MY Al’ sur Snapchat. Cette question est peut-être liée à une personne spécifique ou à un pseudonyme.

Comment avoir my ai Snapchat ?

Il n’est actuellement pas possible d’avoir un AI spécifique sur Snapchat. Snapchat n’offre pas d’options pour les utilisateurs d’intégrer ou de développer leur propre IA pour l’application.

Comment enlever un avatar sur SNAP ?

Pour supprimer un avatar sur Snapchat, allez dans les paramètres de l’application et tapez sur ‘Bitmoji’. Ensuite, appuyez sur ‘Détacher mon Bitmoji’ pour le supprimer.

L’article Guide Pas à Pas pour Supprimer My AI : Un Tutoriel Simplifié est apparu en premier sur Astuces Tech.

Geeko Magazine Special Edition 2023冬号を発行します

この投稿は openSUSE Advent Calendar の18日目です。

今年もこの時期がやってきました。12月31日に開催されるコミックマーケットC103において、Geeko Magazine Special Edition 2023冬 を発行します。

今回の内容は次のとおりです。

- 「最先端OS ALPを体感」開発中の Adaptive Linux Platform を実際にインストールして、Cockpit による管理や、GNOME を試してみました。

- 「Ignition で自動設定、Cockpit で管理―openSUSE Leap Micro を使ってみよう」コンテナホスト向け Leap の Leap Micro の簡単な使い方です。Ignition でインストールを自動化し、Cockpit で Redmine をデプロイする方法を紹介します。

- 「openSUSEでCephを使ってみる」「GlusterFSを使ってみる」2大分散ファイルシステムについて、16ページを使って紹介します。それぞれ、基本的なアーキテクチャ、インストール、マウント、故障が発生した場合の挙動について解説します。

- 「エーデル・シュティメ 〜とあるカメレオンのタリナイモノとネガウモノ〜」親に男子として育てられた女子高生とAIで動くカメレオン型ぬいぐるみのお話。

- 「Kritaを使ってライブ生成AIなお絵描きしてみよう」Krita上で適当な絵を描くと、その絵を元にAIが絵を生成。

Resurrecting my 3D Printer

Resurrecting my 3D Printer

A few years back I got myself a Monoprice Mini Delta 3d printer. I chose it because it was inexpensive, and self-leveling, so seemed like a great way to get started with the hobby, and it really delivered.

My first print a few years ago:

I started out printing parts to organize my electronics tool bench, and you can see (a lot of the prints I made on thingiverse)[https://www.thingiverse.com/rickspencer3/makes].

I haven't printing in a while though, and I have some free time, and there are a few simple things I wanted to print, so I pulled the printer out of the closet, all covered in dust and everything. First problem, the spool of black PLA that I had left on it had turned rather brittle. So I pulled out the old PLA, and put on a spool of glow in the dark PLA that I happened to have kept in a plastic back with a silicon moisture absorbing pack, so it still seemed good.

In installed Octoprint on my OpenSuse Leap machine and attached it, but I couldn't make it connect. This turned out to be a common problem with my printer and Linux in general (not a Suse-specific issue). On a side note, installing Octoprint with pip3 on Suse was dead easy, a real please.

In any case, I had Octopi running on rpi that is still attached to my workbench, so I scrounged up a power supply for it, attached a tiny monitor, booted it up and ... it still works!

You can see that I was printing out ear savers for face masks, so that gives you a sense of the last time I printed. Since the ear savers are very fast prints, I decided it was a good test print to do, so I decided to start with that, and it worked!

Here you can see the printed ear saver with some of the black PLA still sort of mixed in:

Here's the whole set up printing away:

Overall, I am really happy with the printer and set up. Considering this has all been collecting dust for years, and that I was easily able to get it up and running again with such little drama made me really happy. Now I can move on to getting Cura working and printing some of the new things I wanted to print.

Member

Member baltolkien

baltolkien