Thu, Apr 11th, 2024

Presenta tu charla para Akademy 2024 de Würzburg, Alemania

Este año, el encuentro anual de desarrolladores de la Comunidad KDE se va a celebrar en Würzburg de forma presencial y online, concretamente del 7 al 12 de septiembre. Es por ello que es el momento de animaros si pensáis que podéis aportar algo al evento a participar de forma activa:. Así que presenta tu charla para Akademy 2023 y muestra al mundo tu implicación con el Software Libre.

Presenta tu charla para Akademy 2024 de Würzburg

Este año se me ha pasado por alto compartir con vosotros que Akademy 2024 se realizaría en Würzburg del 7 al 12 de septiembre en una edición que sigue con el formato híbrido ya que sus organizadores ya le han cogido el truco para hacerlo accesible a todo el mundo.

Siguiendo el esquema habitual, las charlas se realizarán el sábado 7 y el domingo 8, dejando el resto de días para el trabajo en pequeños grupos en sala más reservadas pero no privadas, es decir, que no están cerradas sino que todo el que quiera aportar algo está invitado.

Como se ha comentado en anteriores ocasiones, uno de los objetivos de Akademy es aprender y enseñar nuevos conocimientos y compartir entre nosotros la pasión de lo que se hace en KDE.

Para compartir ideas, experiencias o momentos, se reservan talleres específicos en la sede (o se aprovechan los corrillos en los pasillos, las cenas o los momentos de barra), pero para enseñar y compartir detalles técnicos se utilizan las charlas.

Si crees que tienes algo importante que presentar, por favor házselo saber a la organización. Y si crees que alguien debería presentar su ponencia, no dejes de animarlo para que lo haga. Todas las contribuciones son útiles y, si necesitas, inspiración:

- KDE en acción: casos de uso de la tecnología KDE en la vida real; ya sea en dispositivos móviles, implementaciones de escritorio, etc.

- Visión general de lo que está ocurriendo en las distintas áreas de la comunidad KDE.

- Colaboración entre KDE y otros proyectos de Software Libre.

- Publicación, empaquetado y distribución de software por parte de KDE.

- Aumentar nuestro alcance a través de esfuerzos como la accesibilidad, la promoción, la traducción y la localización.

- Mejora de nuestra gobernanza y procesos, construcción de la comunidad.

- Temas relacionados con los objetivos de KDE.

- Innovaciones y mejores prácticas en las bibliotecas y tecnologías utilizadas por el software de KDE, por ejemplo, C++/Qt/Python/KDE Frameworks/etc. o que puedan ser interesantes para su uso futuro, por ejemplo, Rust/C++20, etc.

Para más detalles, mira las líneas generales del Call for Papers. Tienes de plazo para enviar tu propuesta hasta el jueves 14 de mayo 23:59:59 CEST.

¿Qué es Akademy?

Para los que no lo sepan, Akademy es el evento de la Comunidad KDE que aúna en una gran conferencia todo tipo de simpatizantes de KDE como desarrolladores, diseñadores, usuarios, traductores, promotores, ideólogos, etc. Allí se reunirán a lo largo de una semana para compartir charlas, cenas, ponencias, talleres y, en definitiva, para trabajar juntos.

Es una gran semana que sirve para unir más fuerte los lazos que unen nuestra Comunidad, así como para crear nuevos que se mantendran gracias a las listas de correo, canales irc o Sprints.

La entrada Presenta tu charla para Akademy 2024 de Würzburg, Alemania se publicó primero en KDE Blog.

Wed, Apr 10th, 2024

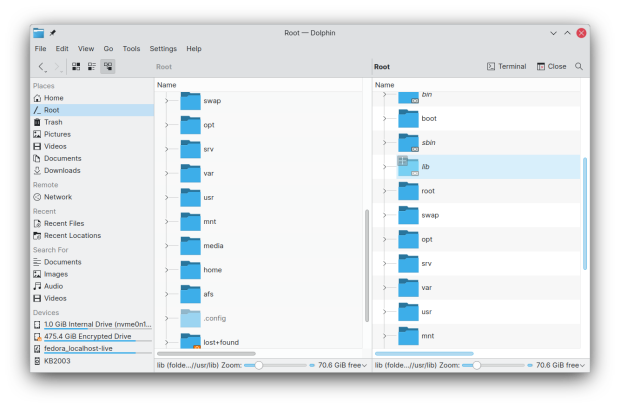

Novedades de Dolphin en KDE Gear 24.02

Plasma 6 no vino solo. Junto al escritorio también apareció KDE Gear 24.02, KDE Frameworks 6 y Plasma Mobile 6, todo un desembarco de novedades que todavía no han tenido tiempo de aparecer en el blog. Es hora de enmendar este error. Ya hice un resumen básico de las cosas nuevas que nos ofrecían y es el momento de hablar de las novedades de Dolphin en KDE Gear 24.02, el explorador de archivos y carpetas de la Comunidad KDE que es una verdadera navaja suiza para cualquier usuario.

Novedades de Dolphin en KDE Gear 24.02

La calidad y cantidad de aplicaciones del ecosistema KDE es asombrosa, creciente y realmente competente. Solo hay que ver la página oficial para ver el catálogo completo de ellas.

En el salto tecnológico del pasado 28 de febrero, KDE Gear 24.02 nos trajo muchas aplicaciones ya migradas a Qt 6 y con un aspecto con menos marcos en su interfaz, con el objetivo de hacerlos más consistentes con Brisa y que tengan un aspecto más moderno.

Dolphin ha recibido una atención especial a la hora de aplicar esas mejoras estéticas pero evidentemente, sus novedades no se acaban ahí. De este modo, las preferencias de configuración del explorador han recibido una atención especial y se han reorganizado para que sea más fácil navegar por ellas.

También hay mejoras de accesibilidad en esta versión. Ahora se puede acceder con el teclado a los botones de la barra de herramientas y al indicador de espacio libre en disco de la barra de estado. Se puede pulsar F10 para abrir el menú principal y Mayúsculas+F10 para abrir menús de contexto. Algunas de estas mejoras se han aplicado también a otras aplicaciones.

Para finaliza comentar que al hacer clic con el botón derecho sobre una carpeta se muestra una opción para abrirla en una vista dividida.

En próximas entradas nos seguiremos con detalles específicos de otras aplicaciones. ¡¿No es asombroso para algo realizado por voluntarios?!

Más información: KDE

La entrada Novedades de Dolphin en KDE Gear 24.02 se publicó primero en KDE Blog.

8BitDo C64 Edition Mechanical Keyboard

Tue, Apr 9th, 2024

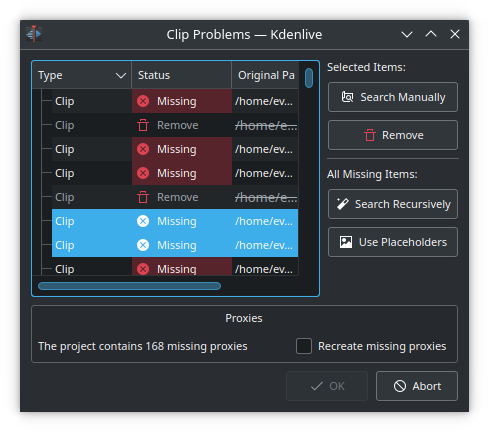

Novedades de Kdenlive en KDE Gear 24.02

Plasma 6 no vino solo. Junto al escritorio también apareció KDE Gear 24.02, KDE Frameworks 6 y Plasma Mobile 6, todo un desembarco de novedades que todavía no han tenido tiempo de aparecer en el blog. Es hora de enmendar este error. Ya hice un resumen básico de las cosas nuevas que nos ofrecían y es el momento de hablar de las novedades de Kdenlive en KDE Gear 24.02, el editor de vídeo no lineal de la Comunidad KDE.

Novedades de Kdenlive en KDE Gear 24.02

La calidad y cantidad de aplicaciones del ecosistema KDE es asombrosa, creciente y realmente competente. Solo hay que ver la página oficial para ver el catálogo completo de ellas.

En el salto tecnológico del pasado 28 de febrero, KDE Gear 24.02 nos trajo muchas aplicaciones ya migradas a Qt 6 y con un aspecto con menos marcos en su interfaz, con el objetivo de hacerlos más consistentes con Brisa y que tengan un aspecto más moderno.

Y, además de todo eso, muchas aplicaciones han ganado nuevas funcionalidades, y Kdenlive no es ninguna excepción.

La gran novedad del potente editor de vídeo de KDE es la posibilidad de sustituir el audio o el vídeo de un videoclip en la línea de tiempo. Esta nueva función permite extraer el sonido de un videoclip, modificarlo en otro programa y volver a insertarlo en el videoclip.

Por otra parte, la función de subtítulos de Kdenlive se ha mejorado bastante, y ahora permite incorporar múltiples subtítulos en una misma pista. Esto es especialmente útil para los vídeos que exigen subtítulos en varios idiomas. También dispone de la opción de importar y exportar subtítulos.

Además, ahora Kdenlive nos avisará cuando exista una actualización del programa, incluso sin la necesidad de que exista una conexión a internet.

Para finalizar el monitor de videoclips mostrará todos los que haya abierto recientemente y el diálogo de comprobación de documentos, que se muestra al abrir un proyecto con videoclips ausentes, se ha reescrito completamente.

En próximas entradas nos seguiremos con detalles específicos de otras aplicaciones. ¡¿No es asombroso para algo realizado por voluntarios?!

Más información: KDE

La entrada Novedades de Kdenlive en KDE Gear 24.02 se publicó primero en KDE Blog.

Default wallpaper has common path across openSUSE, SUSE

We will be newly using png for the default wallpaper set on openSUSE Tumbleweed and upcoming versions of openSUSE Leap and Leap Micro.

The driver behind the decision is the unification of wallpaper paths with SUSE Linux Enterprise via a compatibility symlink because the format had to be the same. SLES and SLED have been using PNG since the last rebrand in SLE 15 Service Pack 3 and openSUSE has been using JPG up until now.

Using a common default wallpaper path allows applications utilizing wallpaper or similar system branding to be re-run on SLES and openSUSE without a need to be rebuilt.

The small price for using the lossless format is a slight increase in size, however, we do use optipng so it’s within units of megabytes for all wallpapers resolutions combined.

ls -la /usr/share/wallpapers/openSUSEdefault/contents/images/1600x1200.png

-rw-r--r-- 1 root root 417791 Apr 5 13:14 /usr/share/wallpapers/openSUSEdefault/contents/images/1600x1200.png

ls -la /usr/share/wallpapers/SLEdefault/contents/images/1600x1200.png

-rw-r--r-- 1 root root 417791 Apr 5 13:14 /usr/share/wallpapers/SLEdefault/contents/images/1600x1200.png

ls -la /usr/share/wallpapers/SLEdefault

lrwxrwxrwx 1 root root 15 Apr 5 13:15 /usr/share/wallpapers/SLEdefault -> openSUSEdefault

We’ve also supplied new apple-touch-icon, which was part of SUSE Linux Enterprise distribution logos and this was missing on the openSUSE side.

Since this is effectively a change of a default wallpaper we recommend users who use the default wallpaper to log out and log in to avoid any glitches.

Please ensure the system was able to re-read /usr/share/wallpapers/openSUSE-default-static.xml

The great news about this is that we plan to come up with a new wallpaper collection for openSUSE Leap 16 as well as openSUSE Tumbleweed, which hasn’t seen a wallpaper change for a while; just view it as a nice little fire drill.

Steam Games Using the Discrete AMD GPU on Haswell Laptop

Mon, Apr 8th, 2024

KDE estará en 42 Barcelona

Con el título provisional de «KDE – Impulsa a tu carrera profesional a través del software libre» Albert Astals Cid, miembro fundador de KDE España realizará una charla con el objetivo de mostrar cómo se aprende sobre software libre con KDE.

KDE estará en 42 Barcelona

Con esta será la segunda vez, y esperemos que no se la última, en la que la Comunidad KDE mostrará algunas de las razones por las que participar en un proyecto libre como KDE es una de las mejores opciones para formarte como profesional del Software al tiempo que dedicas tu tiempo a «hacer del mundo un lugar mejor» (cita extraída de la gran serie «Silicon Valley»). La charla tendrá lugar el 17 de abril a las 18.00 hora peninsular.

Pronto, más información.

Incripción en Evenbrite

Qué és 42 Barcelona?

42 Barcelona és el campus de programació més innovador i gratuït que t’obre les portes al mercat laboral. Amb una metodologia revolucionària i una durada mitjana de tres anys, està obert les 24 hores del dia, 7 dies a la setmana perquè puguis aprendre al teu ritme.

Per formar part de 42 Barcelona no necessites coneixements previs ni titulació de cap mena, només tenir més de 18 anys, ganes d’aprendre, actitud i perseverança. Només cal superar dues fases: un test d’inscripció online i un període de selecció presencial de 26 dies.

Les inscripcions sempre estan obertes als campus de Barcelona, Urduliz, Màlaga i Madrid. Descobreix aquesta formació única!

¿Qué es 42 Barcelona?

42 Barcelona es el campus de programación más innovador y gratuito que te abre las puertas al mercado laboral. Con una metodología revolucionaria y una duración media de tres años, está abierto las 24 horas del día, 7 días a la semana para que puedas aprender a tu ritmo.

Para formar parte de 42 Barcelona no necesitas conocimientos previos ni titulación de ningún tipo, solo tener más de 18 años, ganas de aprender, actitud y perseverancia. Solo hay que superar dos fases: un test de inscripción online y un periodo de selección presencial de 26 días.

Las inscripciones siempre están abiertas en los campus de Barcelona, Urduliz, Málaga y Madrid. ¡Descubre esta formación única!

Más información: 42 Barcelona

La entrada KDE estará en 42 Barcelona se publicó primero en KDE Blog.

Centralized system and LSF logging on a Turing Pi system

I love high performance computers, and some of my best friends work in high performance computing (HPC). Obviously, sometimes we also talk about logging. Recently we not just talked, but I also helped Gábor in his first steps with syslog-ng. He summarized his experiences in a blog:

Logs are one of those indispensable things in IT when things go wrong. Having worked in technical support for software products in a past life, I’ve likely looked at hundreds (or more) logs over the years, helping to identify issues. So, I really appreciate the importance of logs, but I can honestly say that I never really thought about a logging strategy for the systems on my home network - primarily those running Linux.

One of my longtime friends, Peter Czanik, who also works in IT, happens to be a logging guru as well as an IBM Champion for Power Systems (yeah!). So it’s only natural that we get to talking about logging. He is often complaining that even at IT security conferences people are unaware of the importance of central logging. So, why is it so important? For security it’s obvious: logs are stored independently from the compromised system, so they cannot be modified or deleted by the attacker. But central logging is beneficial for the HPC operator as well. First of all, it’s availability. You can read the logs even if one of your nodes becomes unreachable. Instead of trying to breath life into the failed node, you can just take a look at the logs and see a broken hard drive, or a similar deadly problem. And it is also convenience, as all logs are available at a single location. Logging into each node on the 3 node cluster to check locally saved logs is inconvenient but doable. On a 10 node cluster it takes a long time. On a 100 node cluster a couple of working days. While, if your logs are collected to a central location, maybe a single grep command, or search in a Kibana or similar web interface.

Those who follow my blog will know that I’ve been tinkering with a Turing Pi V1 system lately. You can read my latest post here. For me, the Turing Pi has always been a cluster in a box. My Turing Pi is fully populated with 7 compute modules. I’ve designed Node 1 to be the NFS server and LSF manager for the cluster. LSF is a workload scheduler for high-performance computing (HPC) from IBM. Naturally I turned to Peter for his guidance on this, and the result is this blog. Peter recommended that I use syslog-ng for log aggregation and also helped me through some of my first steps with syslog-ng. And the goal was to aggregate both the system (syslog) as well as LSF logs on Node 1. TL;DR it was easy to get it all working. But I encourage you to read on to better understand the nuances and necessary configuration both syslog-ng and LSF that was needed.

Read the rest at: https://www.gaborsamu.com/blog/turingpi_syslog-ng_lsf/

syslog-ng logo

Steam’s New Family Share | A Digital Dream Come True

Member

Member baltolkien

baltolkien